Argomenti di tendenza

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

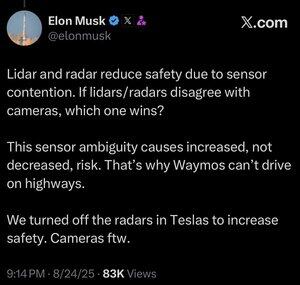

Non sono sicuro che questo abbia senso. È vero che Elon è molto più intelligente di me, ma ecco il mio parere:

Non penso che la fusione dei sensori sia impossibile, rende solo il sistema molto più complicato. Posso vedere un oggetto, toccarlo, annusarlo, e il mio cervello può unire tutto questo in modo naturale. Non credo che la fusione dei sensori sia intrinsecamente meno sicura, ma aumenta la complessità del sistema e il numero di punti di guasto. Il principale problema di Tesla era che il radar a bordo era a bassa risoluzione.

Waymo non può ancora guidare in autostrada con i clienti, in parte a causa della portata dei sensori LIDAR e della loro regolazione per la guida ad alta velocità. E a causa del rischio aggiuntivo delle alte velocità. Ma ora stanno effettivamente circolando in autostrada senza nessuno al volante e permettendo ai dipendenti di sperimentare. Quindi non penso sia giusto dire che non possono guidare in autostrada, semplicemente non si sentono a proprio agio nel farlo utilizzare ai clienti ancora.

Il mio argomento preferito sul perché l'apprendimento profondo batte un approccio multi-sensore è che il grande dataset che puoi costruire con una singola modalità di sensore a basso costo è estremamente potente per aumentare l'accuratezza predittiva del modello. Puoi avere tutti questi sensori sofisticati, ma se significa che il tuo dataset è una frazione della dimensione, diversità, ecc., allora un modello solo visivo potrebbe effettivamente superare in accuratezza predittiva e quindi in sicurezza.

Sono d'accordo con lui che solo la visione è migliore, ma non penso che il nocciolo della questione sia la fusione dei sensori.

232,25K

Principali

Ranking

Preferiti