Tendencias del momento

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

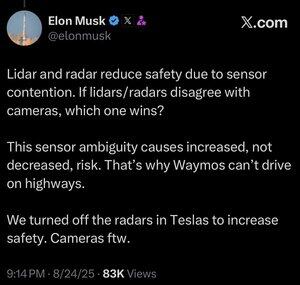

No estoy seguro de que esto tenga sentido. Es cierto que Elon es mucho más inteligente que yo, pero aquí están mis dos centavos:

No creo que la fusión de sensores sea imposible, solo hace que el sistema sea mucho más complicado. Puedo ver un objeto, tocarlo, olerlo, y mi cerebro puede fusionar todo eso de manera natural. No creo que la fusión de sensores sea inherentemente menos segura, pero aumenta la complejidad del sistema y el número de puntos de fallo. El principal problema de Tesla era que su radar en el coche tenía una resolución tan baja.

Waymo aún no puede conducir en autopistas con clientes, en parte debido al alcance de los sensores LIDAR y la calibración para la conducción a alta velocidad. Y por el riesgo adicional de las altas velocidades. Pero ahora están realmente circulando por autopistas sin nadie en el asiento del conductor y dejando que los empleados jueguen con eso. Así que no creo que sea justo decir que no pueden conducir en autopistas, simplemente no se sienten cómodos dejándole a los clientes usarlo todavía.

Mi argumento favorito de por qué el aprendizaje profundo supera un enfoque de múltiples sensores es que el conjunto de datos a gran escala que puedes construir con una única modalidad de sensor de bajo costo es extremadamente poderoso para aumentar la precisión predictiva del modelo. Puedes tener todos estos sensores elegantes, pero si eso significa que tu conjunto de datos es una fracción del tamaño, diversidad, etc., entonces un modelo solo de visión podría superar en precisión predictiva y, por lo tanto, en seguridad.

Estoy de acuerdo con él en que solo la visión es mejor, pero no creo que la clave de eso sea la fusión de sensores.

232,3K

Parte superior

Clasificación

Favoritos