Trend-Themen

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

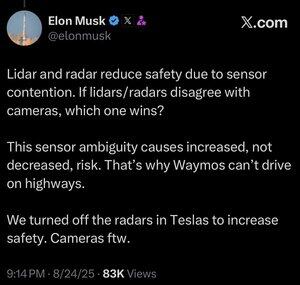

Ich bin mir nicht sicher, ob das Sinn macht. Zugegeben, Elon ist viel schlauer als ich, aber hier sind meine 2 Cent:

Ich denke nicht, dass Sensorfusion unmöglich ist, sie macht das System nur viel komplizierter. Ich kann ein Objekt sehen, es berühren, es riechen, und mein Gehirn kann das alles ganz natürlich zusammenfügen. Ich denke nicht, dass Sensorfusion von Natur aus weniger sicher ist, aber sie erhöht die Komplexität des Systems und die Anzahl der Fehlerquellen. Teslas Hauptproblem war, dass ihr Radar im Auto eine so niedrige Auflösung hatte.

Waymo kann noch nicht mit Kunden auf Autobahnen fahren, teilweise wegen der Reichweite der LIDAR-Sensoren und der Abstimmung für das Fahren mit hoher Geschwindigkeit. Und wegen des zusätzlichen Risikos bei hohen Geschwindigkeiten. Aber sie fahren tatsächlich jetzt auf Autobahnen, ohne dass jemand am Steuer sitzt, und lassen Mitarbeiter damit experimentieren. Daher denke ich, dass es unfair ist zu sagen, sie können nicht auf Autobahnen fahren, sie fühlen sich nur noch nicht wohl dabei, Kunden das zu erlauben.

Mein Lieblingsargument, warum Deep Learning einen Multi-Sensor-Ansatz übertrifft, ist, dass der groß angelegte Datensatz, den man mit einer einzigen kostengünstigen Sensormodality aufbauen kann, extrem leistungsstark ist, um die Vorhersagegenauigkeit des Modells zu erhöhen. Vielleicht habt ihr all diese schicken Sensoren, aber wenn das bedeutet, dass euer Datensatz nur einen Bruchteil der Größe, Vielfalt usw. hat, könnte ein rein visuelles Modell tatsächlich in der Vorhersagegenauigkeit und damit in der Sicherheit überlegen sein.

Ich stimme ihm zu, dass nur Vision besser ist, aber ich denke nicht, dass der Kern davon die Sensorfusion ist.

232,26K

Top

Ranking

Favoriten