Popularne tematy

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

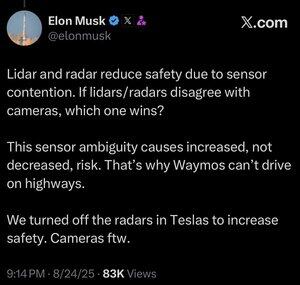

Nie jestem pewien, czy to ma sens. Owszem, Elon jest znacznie mądrzejszy ode mnie, ale oto moje 2 grosze:

Nie sądzę, że fuzja sensorów jest niemożliwa, po prostu sprawia, że system staje się znacznie bardziej skomplikowany. Widzę obiekt, dotykam go, czuję jego zapach, a mój mózg potrafi to wszystko naturalnie połączyć. Nie sądzę, że fuzja sensorów jest z natury mniej bezpieczna, ale zwiększa złożoność systemu i zwiększa liczbę punktów awarii. Głównym problemem Tesli było to, że ich radar w samochodzie miał tak niską rozdzielczość.

Waymo nie może jeszcze jeździć po autostradach z pasażerami, częściowo z powodu zasięgu czujników LIDAR i dostosowania ich do jazdy z dużą prędkością. A także z powodu dodatkowego ryzyka związanego z dużymi prędkościami. Ale teraz faktycznie jeżdżą po autostradach bez nikogo na miejscu kierowcy i pozwalają pracownikom bawić się tym. Więc nie sądzę, że sprawiedliwe jest mówienie, że nie mogą jeździć po autostradach, po prostu nie czują się jeszcze komfortowo, pozwalając klientom z tego korzystać.

Moim ulubionym argumentem na rzecz tego, dlaczego uczenie głębokie przewyższa podejście wielosensorowe, jest to, że duża skala zbioru danych, którą można zbudować za pomocą jednego taniego sensora, jest niezwykle potężna w zwiększaniu dokładności predykcyjnej modelu. Możesz mieć wszystkie te wymyślne czujniki, ale jeśli oznacza to, że twój zbiór danych jest ułamkiem rozmiaru, różnorodności itp., to model oparty tylko na wizji może w rzeczywistości przewyższyć pod względem dokładności predykcyjnej, a tym samym bezpieczeństwa.

Zgadzam się z nim, że wizja tylko jest lepsza, ale nie sądzę, że sedno sprawy tkwi w fuzji sensorów.

232,27K

Najlepsze

Ranking

Ulubione