Populární témata

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

Někdo vyzkoušet tento agentic thinker LLM od ByteDance? 👀

Nebo je humbuk kolem čínských modelů s otevřeným zdrojovým kódem na ústupu?

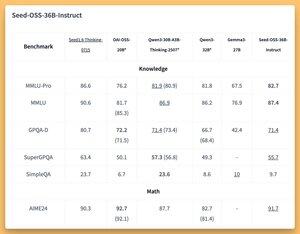

36B Instrukční a Založené modely (dokonce i základ bez syntetických dat) s některými skvělými (SOTA?) lavičkami 🤔

Zítra se budeme věnovat na @thursdai_pod

21. 8. 04:02

ByteDance vydává Seed-OSS (Apache-2.0): otevřená řada LLM (12T tokeny) optimalizovaná pro 512K ctx, uvažování, agentské úkoly, i18n (mezinárodní použití). Vydání obsahuje Seed-OSS-36B-Base (bez syntetických dat) a Seed-OSS-36B-Instruct

- Oblouk: 36B parametry, 64L, skrytý 5120, slovní zásoba 155K, GQA (80/8/8, hlava 128), SwiGLU, RMSNorm, RoPE základna 1e7

- Thinking Budget: Délka kontrolního uvažování (násobky 512), sebereflexe CoT, 0 = přímé odpovědi, výchozí = neomezeně

36B-Base (w/ vs w/o syn.)

- MMLU-Pro 65.1 / 60.4 | MMLU 84.9 / 84.8 | TriviaQA 82.1 / 81.9 | GPQA-D 31,7 / 35,2

- Průměrné hodnocení 87,7 / 87,2 | AGIEval-en 70,7 / 70,1

- GSM8K 90,8 / 90,3 | MATH 81.7 SOTA / 61.3

- MBPP 80,6 / 74,6 | HumanEval 76,8 / 75,6

36B-Instrukce

- MMLU-Pro 82.7 | MMLU 87.4 | GPQA-D 71.4 | SuperGPQA 55.7

- AIME24 91.7 SOTA | AIME25 84.7 | Za hraniceAIME 65

- ArcAGI v2 40.6 | KORBench 70.6

- LiveCodeBench v6 67.4 SOTA | HLE 10.1

- IFEval 85.8 | TAU1-Retail 70.4 SOTA | TAU1-Airline 46

- SWE-Bench Ověřeno 56 SOTA | Multi-SWE-lavice 17

- MMMLU 78.4 | PRAVÍTKO (128K) 94.6 SOTA | AIR-Bench 75.6

Odvození: Transformátory, vLLM (≥0.10.0), FlashAttention2, 4/8bitová kvantizace

168

Top

Hodnocení

Oblíbené