Subiecte populare

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

Încearcă cineva acest gânditor agentic LLM de la ByteDance? 👀

Sau hype-ul din jurul modelelor chinezești open source este scăzut?

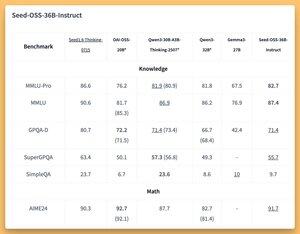

Modele 36B Instruct and Based (chiar și bază fără date sintetice 🤔) cu niște bănci grozave (SOTA?)

Vom acoperi mâine pe @thursdai_pod

21 aug., 04:02

ByteDance lansează Seed-OSS (Apache-2.0): seria deschisă LLM (jetoane 12T) optimizată pentru 512K ctx, raționament, sarcini de agent, i18n (utilizare internațională). Lansarea include Seed-OSS-36B-Base (fără date sintetice) și Seed-OSS-36B-Instruct

- Arch: 36B params, 64L, ascuns 5120, vocabular 155K, GQA (80/8/8, cap 128), SwiGLU, RMSNorm, RoPE base 1e7

- Buget de gândire: Lungimea raționamentului de control (multipli de 512), auto-reflecție CoT, 0 = răspunsuri directe, implicit = nelimitat

36B-Bază (fără sin)

- MMLU-Pro 65.1 / 60.4 | MMLU 84.9 / 84.8 | TriviaQA 82.1 / 81.9 | GPQA-D 31.7 / 35.2

- BBH 87.7 / 87.2 | AGIEval-en 70.7 / 70.1

- GSM8K 90.8 / 90.3 | MATEMATICĂ 81.7 SOTA / 61.3

- MBPP 80.6 / 74.6 | Evaluare umană 76.8 / 75.6

36B-Instruire

- MMLU-Pro 82.7 | MMLU 87.4 | GPQA-D 71.4 | SuperGPQA 55.7

- AIME24 91.7 SOTA | AIME25 84.7 | DincoloAIME 65

- ArcAGI V2 40.6 | KORBench 70.6

- LiveCodeBench v6 67.4 SOTA | HLE 10.1

- IFEval 85.8 | TAU1-Comerț cu amănuntul 70.4 SOTA | TAU1-Compania aeriană 46

- SWE-Bench verificat 56 SOTA | Multi-SWE-Bench 17

- MMMLU 78.4 | RIGLĂ (128K) 94.6 SOTA | AIR-Bench 75.6

Inferență: Transformatoare, vLLM (≥0.10.0), FlashAttention2, cuantizare pe 4/8 biți

166

Limită superioară

Clasament

Favorite