Trendande ämnen

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

Någon prova denna agentic thinker LLM från ByteDance? 👀

Eller är hypen kring kinesiska modeller med öppen källkod nere?

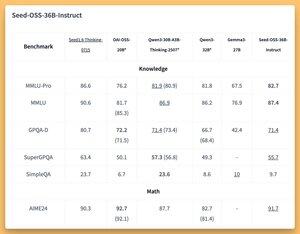

36B Instruera och Baserat modeller (även bas utan syntetiska data) med några fantastiska (SOTA?) bänkar 🤔

Vi kommer att täcka imorgon på @thursdai_pod

21 aug. 04:02

ByteDance släpper Seed-OSS (Apache-2.0): öppen LLM-serie (12T-tokens) optimerad för 512K ctx, resonemang, agentuppgifter, i18n (internationell användning). Releasen innehåller Seed-OSS-36B-Base (w/ & w/o syntetisk data) och Seed-OSS-36B-Instruct

- Båge: 36B params, 64L, dold 5120, vokabulär 155K, GQA (80/8/8, huvud 128), SwiGLU, RMSNorm, RoPE bas 1e7

- Tankebudget: Kontrollera resonemangslängden (multiplar av 512), CoT självreflektion, 0 = direkta svar, standard = obegränsat

36B-bas (w/ vs w/o syn.)

- MMLU-Pro 65,1 / 60,4 | MMLU 84,9 / 84,8 | TriviaQA 82.1 / 81.9 | GPQA-D 31,7 / 35,2

- BBH 87,7 / 87,2 | AGIEval-en 70.7 / 70.1

- GSM8K 90,8 / 90,3 | MATH 81.7 SOTA / 61.3

- MBPP 80,6 / 74,6 | HumanEval 76,8 / 75,6

36B-Instruera

- MMLU-Pro 82,7 | MMLU 87,4 | GPQA-D 71.4 | SuperGPQA 55.7

- AIME24 91.7 SOTA | AIME25 84,7 | BortomAIME 65

- ArcAGI V2 40.6 | KORBench 70.6

- LiveCodeBench v6 67.4 SOTA | HLE 10.1

- IFEval 85.8 | TAU1-Detaljhandel 70.4 SOTA | TAU1-Flygbolag 46

- SWE-bänk verifierad 56 SOTA | Multi-SWE-Bänk 17

- MMMLU 78,4 | LINJAL (128K) 94.6 SOTA | AIR-bänk 75.6

Slutsats: Transformatorer, vLLM (≥0.10.0), FlashAttention2, 4/8-bitars kvantisering

167

Topp

Rankning

Favoriter