Tópicos em alta

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

Alguém experimentou este LLM pensador agente da ByteDance? 👀

Ou o hype em torno dos modelos chineses de código aberto está baixo?

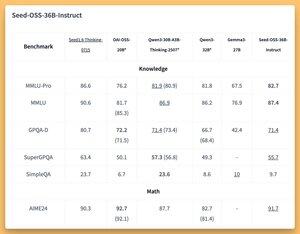

36B Instruir e Basear modelos (mesmo base sem dados sintéticos) com alguns grandes (SOTA?) bancadas 🤔

Vamos cobrir amanhã no @thursdai_pod

21 de ago., 04:02

A ByteDance lança o Seed-OSS (Apache-2.0): série LLM aberta (12T tokens) otimizada para 512K ctx, raciocínio, tarefas de agente, i18n (uso internacional). O lançamento inclui o Seed-OSS-36B-Base (com e sem dados sintéticos) e o Seed-OSS-36B-Instruct

- Arco: 36B parâmetros, 64L, oculto 5120, vocabulário 155K, GQA (80/8/8, cabeça 128), SwiGLU, RMSNorm, RoPE base 1e7

- Orçamento de pensamento: controle o comprimento do raciocínio (múltiplos de 512), autorreflexão do CoT, 0 = respostas diretas, padrão = ilimitado

36B-Base (com vs sem syn.)

- MMLU-Pro 65.1 / 60.4 | MMLU 84.9 / 84.8 | TriviaQA 82.1 / 81.9 | GPQA-D 31.7 / 35.2

- BBH 87,7 / 87,2 | AGIEval-pt 70.7 / 70.1

- GSM8K 90.8 / 90.3 | MATEMÁTICA 81,7 SOTA / 61,3

- MBPP 80.6 / 74.6 | Avaliação Humana 76.8 / 75.6

36B-Instruir

- MMLU-Pro 82.7 | MMLU 87.4 | GPQA-D 71.4 | SuperGPQA 55.7

- AIME24 91,7 SOTA | AIME25 84.7 | Além do AIME 65

- ArcAGI V2 40.6 | KORBench 70.6

- LiveCodeBench v6 67.4 SOTA | HLE 10.1

- IFEval 85.8 | TAU1-Varejo 70.4 SOTA | TAU1-Companhia Aérea 46

- SWE-Bench Verificado 56 SOTA | Banco Multi-SWE 17

- MMMLU 78.4 | RÉGUA (128K) 94.6 SOTA | AIR-Bench 75.6

Inferência: Transformers, vLLM (≥0.10.0), FlashAttention2, quantização de 4/8 bits

178

Melhores

Classificação

Favoritos