トレンドトピック

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

ByteDanceのこのエージェントシンカーLLMを試してみる人はいますか?👀

それとも、オープンソースの中国モデルをめぐる誇大宣伝は減少しているのでしょうか?

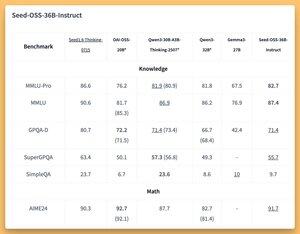

36B インストラクトとベースモデル (合成データのないベースでも) といくつかの優れた (SOTA?) ベンチ 🤔

明日は@thursdai_podで取り上げます

8月21日 04:02

ByteDance が Seed-OSS (Apache-2.0) をリリース: 512K ctx、推論、エージェント タスク、i18n (国際使用) に最適化されたオープン LLM シリーズ (12T トークン)。このリリースには、Seed-OSS-36B-Base (合成データなしおよび合成データなし) と Seed-OSS-36B-Instruct が含まれています

- アーチ: 36B パラメータ、64L、隠し 5120、語彙 155K、GQA (80/8/8、ヘッド 128)、SwiGLU、RMSNorm、RoPE ベース 1e7

- 思考予算:推論の長さ(512の倍数)を制御する、CoT自己反省、0=直接回答、デフォルト=無制限

36B-Base(シンドなしとsyn.)

- MMLU-プロ 65.1 / 60.4 |MMLU 84.9 / 84.8 |トリビアQA 82.1 / 81.9 |GPQA-D 31.7 / 35.2

- BBH 87.7 / 87.2 |AGIEval-en 70.7 / 70.1

- GSM8K 90.8 / 90.3 |数学 81.7 SOTA / 61.3

- MBPP 80.6 / 74.6 |ヒューマン評価 76.8 / 75.6

36B-指示

- MMLU-プロ 82.7 |MMLU 87.4 |GPQA-D 71.4 |スーパーGPQA 55.7

- AIME24 91.7 ソタ |AIME25 84.7 |ビヨンドAIME 65

- アーキ V2 40.6 |コーベンチ 70.6

- LiveCodeBench v6 67.4 ソタ |HLE10.1

- IFEval 85.8 |TAU1-小売 70.4 SOTA |TAU1-エアライン46

- SWE-Bench 検証済み 56 SOTA |マルチスウェーベンチ 17

- MMMLU 78.4 |ルーラー (128K) 94.6 ソータ |エアベンチ 75.6

推論:Transformers、vLLM(≥0.10.0)、FlashAttention2、4/8ビット量子化

169

トップ

ランキング

お気に入り