Topik trending

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

Ada yang mencoba pemikir agen LLM dari ByteDance ini? 👀

Atau apakah hype seputar model Cina open source menurun?

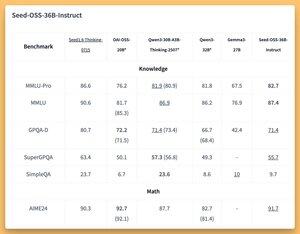

Model 36B Instruct and Based (bahkan basis tanpa data sintetis) dengan beberapa bangku 🤔 (SOTA?) yang bagus

Kami akan membahas besok di @thursdai_pod

21 Agu, 04.02

ByteDance merilis Seed-OSS (Apache-2.0): seri LLM terbuka (token 12T) yang dioptimalkan untuk 512K ctx, penalaran, tugas agen, i18n (penggunaan internasional). Rilis ini mencakup Seed-OSS-36B-Base (dengan & tanpa data sintetis) dan Seed-OSS-36B-Instruct

- Lengkungan: 36B param, 64L, tersembunyi 5120, kosakata 155K, GQA (80/8/8, kepala 128), SwiGLU, RMSNorm, basis RoPE 1e7

- Anggaran Berpikir: Kontrol panjang penalaran (kelipatan 512), refleksi diri CoT, 0 = jawaban langsung, default = tidak terbatas

36B-Base (dengan vs tanpa sink.)

- MMLU-Pro 65.1 / 60.4 | MMLU 84.9 / 84.8 | TriviaQA 82.1 / 81.9 | GPQA-D 31.7 / 35.2

- BBH 87.7 / 87.2 | AGIEval-id 70.7 / 70.1

- GSM8K 90.8 / 90.3 | MATEMATIKA 81.7 SOTA / 61.3

- MBPP 80.6 / 74.6 | HumanEval 76.8 / 75.6

36B-Instruksi

- MMLU-Pro 82.7 | MMLU 87.4 | GPQA-D 71.4 | SuperGPQA 55.7

- AIME24 91.7 SOTA | AIME25 84.7 | MelampauiAIME 65

- ArcAGI V2 40.6 | KORBench 70.6

- LiveCodeBench v6 67.4 SOTA | NOMOR 10.1

- IFEval 85.8 | TAU1-Ritel 70.4 SOTA | TAU1-Maskapai 46

- SWE-Bench Diverifikasi 56 SOTA | Multi-SWE-Bench 17

- MMMLU 78.4 | PENGGARIS (128K) 94.6 SOTA | BANGKU UDARA 75.6

Kesimpulan: Transformator, vLLM (≥0.10.0), FlashAttention2, kuantisasi 4/8-bit

158

Teratas

Peringkat

Favorit