Temas en tendencia

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

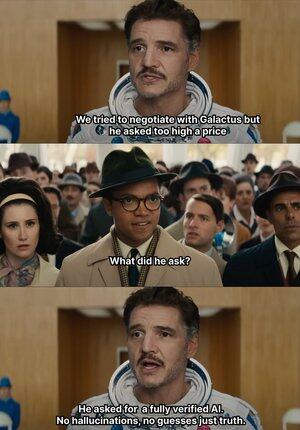

Cuando la IA comienza a inventar cosas, @Mira_Network simplemente levanta la mano y da una bofetada 😂

Voy a contar algo interesante, en 2023 un abogado veterano de Nueva York presentó un dictamen legal ante un tribunal federal.

Los documentos parecían no tener fallas, pero el juez lo vio de inmediato, todos los casos mencionados en el texto no existían, resultó que eran todos inventados por ChatGPT.

Desde que OpenAI se convirtió en nuestra herramienta generativa principal para trabajar y aprender en 2023.

Antes, solía buscar información en Baidu y Google, ahora solo necesito que GPT me resuma.

Con el tiempo, me he acostumbrado a esto, la comida llega a la boca y la ropa se extiende, ni siquiera me molesto en verificar la veracidad, simplemente lo adopto.

La IA, incluso si inventa cosas, nadie sabe qué es verdad o mentira, lo que dará lugar a muchos incidentes confusos.

Porque mientras el lenguaje sea fluido y la lógica sea razonable, puede engañar a la gran mayoría de las personas.

Pero en realidad, no se puede culpar completamente a la IA, la salida de la IA está aumentando, pero la capacidad de verificación casi se ha estancado, el problema de las alucinaciones se ha convertido en un riesgo estructural.

Es en este contexto que la red de verificación de salida de IA de @Mira_Network se ha convertido en una necesidad urgente.

@Mira_Network establece una red de verificación compuesta por múltiples modelos, utilizando juicios cruzados entre sistemas para compensar el problema de que un solo modelo no puede auto-verificarse.

▪️ El primer paso es descomponer la declaración.

Cualquier salida compleja se descompondrá en una serie de afirmaciones más básicas.

Por ejemplo: "La Tierra gira alrededor del Sol" y "La Luna gira alrededor de la Tierra" se descompondrán en dos declaraciones independientes, cada una de las cuales puede ser juzgada por separado.

A continuación, múltiples modelos se conectan al proceso de verificación, cada modelo da un juicio independiente, el sistema contabiliza el grado de consenso entre ellos y evalúa el nivel de confianza.

Si el consenso supera el umbral, la afirmación se considera válida; si hay una gran discrepancia, se activa una segunda revisión o se rechaza.

▪️ Los datos de las pruebas de verificación de Mira muestran:

> El mecanismo de consenso de tres modelos aumentó la precisión del 73.1% al 95.6%.

> La tasa de error general disminuyó en un 84%.

> El valor de consistencia promedio κ entre múltiples modelos se acerca a 0.8, lo que ya proporciona una capacidad de juicio estable.

Por supuesto, si solo se permite que varios modelos voten para juzgar la veracidad, es fácil que surjan comportamientos de adivinanza aleatoria.

▪️ La razón por la que Mira puede funcionar es porque ha incorporado un mecanismo de juego en la estructura del sistema.

La verificación no es una acción sin costo. Cada nodo de modelo que participa en la verificación debe asumir la responsabilidad de los resultados.

Si frecuentemente entra en conflicto con otros nodos en sus juicios, o se detecta que se desvía claramente de la lógica, perderá su derecho de verificación y perderá los incentivos económicos en la red.

Para que la verificación se implemente realmente, Mira ha realizado una gran cantidad de optimizaciones en la arquitectura de ejecución.

▪️ Uno de los aspectos más críticos es: comprimir la salida de verificación en un solo token.

Esta técnica de transformación de reclamos reduce enormemente el costo de cada verificación, permitiendo que el sistema funcione en escenarios de aplicación a gran escala sin ser abrumado.

▪️ En términos de privacidad, los nodos de verificación de Mira nunca acceden al texto completo.

El sistema descompone automáticamente el contenido y lo distribuye a diferentes nodos, garantizando la irreversibilidad de los datos durante el proceso de verificación.

En el último año, la IA se ha llevado a más y más escenarios, la velocidad de generación ha aumentado, pero el mecanismo de verificación se ha estancado.

La IA puede decir tonterías sin ser responsabilizada, pero las personas sí 😭

Así que el papel de @MiraNetworkCN es intervenir cuando la IA está hablando sin sentido.

2.18K

Populares

Ranking

Favoritas