Populaire onderwerpen

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

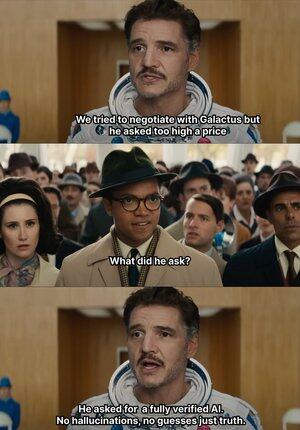

Wanneer AI begint te verzinnen, geeft @Mira_Network meteen een klap 😂

Laat me een interessant verhaal vertellen: in 2023 diende een ervaren advocaat uit New York een juridisch advies in bij de federale rechtbank.

De informatie leek geen gebreken te vertonen, maar werd door de rechter in één oogopslag doorzien; alle in de tekst genoemde gevallen bestonden niet, en het bleek dat ze allemaal door ChatGPT waren verzonnen.

Sinds 2023 is OpenAI een mainstream generatietool geworden voor ons werk en leren.

Voorheen zocht ik meestal informatie via Baidu of Google, nu heb ik alleen GPT nodig om het voor me samen te vatten.

Zo is het een gewoonte geworden; ik ben lui geworden en neem het gewoon aan zonder de waarheid te verifiëren.

AI kan, zelfs als het onzin vertelt, niemand weet wat waar of niet waar is, wat leidt tot veel misverstanden.

Want zolang de taal soepel is en de logica redelijk, kan het de meeste mensen misleiden.

Maar eigenlijk kan je dit niet alleen AI verwijten; de output van AI neemt toe, maar de verificatiecapaciteit is vrijwel stil blijven staan, en het hallucinatieprobleem is een structureel risico geworden.

Juist in deze context is het AI-outputverificatienetwerk van @Mira_Network een dringende behoefte geworden.

@Mira_Network heeft een verificatienetwerk opgebouwd dat uit meerdere modellen bestaat, waarbij kruisbeoordelingen tussen systemen de tekortkomingen van individuele modellen compenseren.

▪️ De eerste stap is het ontleden van de verklaring.

Elke complexe output wordt ontleed in een reeks meer basale beweringen.

Bijvoorbeeld: de aarde draait om de zon, de maan draait om de aarde, dit wordt opgesplitst in twee onafhankelijke zinnen, die elk afzonderlijk op waar of niet waar kunnen worden beoordeeld.

Vervolgens worden meerdere modellen in het verificatieproces betrokken; elk model geeft onafhankelijk een oordeel, en het systeem berekent de mate van consensus tussen hen en evalueert de betrouwbaarheid.

Als de consensus boven de drempel ligt, wordt de bewering als geldig beschouwd; als er ernstige meningsverschillen zijn, wordt een tweede controle of afwijzing geactiveerd.

▪️ Gegevens van Mira's testverificatie tonen aan:

> De consensusmechanisme van drie modellen verhoogt de nauwkeurigheid van 73,1% naar 95,6%.

> De totale foutenmarge daalt met 84%.

> De gemiddelde consistentie κ-waarde tussen meerdere modellen nadert 0,8, wat een stabiele beoordelingscapaciteit aantoont.

Natuurlijk, als je alleen maar meerdere modellen laat stemmen over waar of niet waar, is het gemakkelijk om willekeurige gokgedrag te krijgen.

▪️ De reden dat Mira kan functioneren, is omdat het een spelmechanisme in de systeemstructuur heeft ingebed.

Verificatie is geen kosteloze handeling. Elk model dat deelneemt aan de verificatie moet verantwoordelijk zijn voor de resultaten.

Als het vaak in conflict komt met andere knooppunten of duidelijk afwijkt van de logische lijn, verliest het zijn verificatierecht en verliest het economische prikkels binnen het netwerk.

Om ervoor te zorgen dat verificatie echt wordt uitgevoerd, heeft Mira veel engineeringoptimalisaties in de uitvoeringsstructuur aangebracht.

▪️ De belangrijkste is: het comprimeren van de verificatie-output tot een enkele token.

Deze claimtransformatie-technologie verlaagt de kosten van elke verificatie aanzienlijk, waardoor het systeem kan functioneren in grootschalige toepassingsscenario's zonder de doorvoer te verzwakken.

▪️ Wat betreft privacy, de verificatieknooppunten van Mira hebben nooit toegang tot de volledige tekst.

Het systeem splitst automatisch de inhoud en verspreidt deze naar verschillende knooppunten, waardoor de onherleidbaarheid van gegevens tijdens het verificatieproces wordt gegarandeerd.

In het afgelopen jaar is AI in steeds meer scenario's geduwd, met een steeds snellere generatie, maar het verificatiemechanisme is vrijwel stil blijven staan.

AI kan onzin vertellen zonder verantwoordelijk te worden gehouden, maar mensen wel 😭

Dus de rol van @MiraNetworkCN is om in te grijpen wanneer AI onzin vertelt.

2,19K

Boven

Positie

Favorieten