Subiecte populare

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

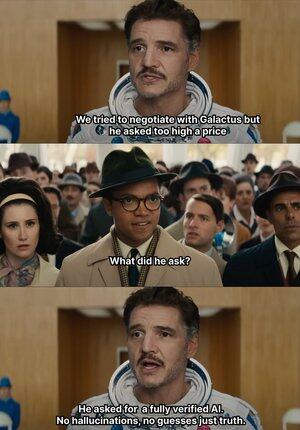

Când AI-ul începe să se împace orbește, @Mira_Network ridică direct mâna și o plesnește 😂

Într-o notă interesantă, în 2023, un avocat senior din New York a depus un aviz juridic la instanța federală

Datele par să nu aibă defecte, dar judecătorul le-a văzut dintr-o privire și niciunul dintre cazurile enumerate în articol nu a existat, dar nu mă așteptam să fie fabricate de ChatGPT

Din 2023, OpenAI a devenit instrumentul generativ principal pentru învățarea noastră la birou

Înainte de asta, de obicei trebuia să caut Baidu și Google pentru a găsi informații, dar acum am nevoie doar de GPT pentru a le rezuma

În acest fel, mi-am dezvoltat obiceiul de a căuta mâncare și sunt prea leneș pentru a verifica autenticitatea și adoptarea directă a acesteia

Chiar dacă AI inventează, nimeni nu știe dacă este adevărat sau fals, se vor naște multe incidente oolong

Pentru că atâta timp cât limbajul este lin și logic, poate înșela marea majoritate a oamenilor

Dar, de fapt, acest gen de lucruri nu se poate baza în întregime pe AI, AI iese din ce în ce mai mult, dar capacitatea de verificare este aproape stagnantă, iar problema halucinațiilor a devenit un risc structural

În acest context, rețeaua de verificare a rezultatelor AI a @Mira_Network devenit o nevoie rigidă

@Mira_Network Stabilirea unei rețele de verificare compusă din mai multe modele și utilizarea judecății încrucișate între sisteme pentru a compensa problema că un singur model nu se poate autocertifica

▪️ Primul pas este să descompuneți declarația

Orice rezultat complex este împărțit într-o serie de revendicări mai de bază

De exemplu, Pământul se învârte în jurul Soarelui și Luna se învârte în jurul Pământului în două afirmații independente, fiecare dintre ele putând fi judecată separat ca fiind adevărată sau falsă

Apoi, mai multe modele sunt conectate la procesul de verificare, iar fiecare model emite judecăți în mod independent, iar sistemul va număra gradul de consens dintre ele și va evalua gradul de încredere

Dacă consensul este peste prag, afirmația este considerată validă; Dacă dezacordul este grav, se declanșează o a doua verificare sau concediere

▪️ Datele din validarea testului Mira arată:

> Mecanismul de consens cu trei modele îmbunătățește acuratețea de la 73,1% la 95,6%

> reducere cu 84 % a ratei de eroare globale

> Valoarea medie a consistenței κ între mai multe modele este aproape de 0,8, ceea ce are o capacitate stabilă de judecată

Desigur, dacă lași mai multe modele să voteze pentru a judeca adevărul, este ușor să ghicești la întâmplare

▪️Mira funcționează pentru că încorporează mecanica jocului în structura sistemului

Validarea nu este un act gratuit. Fiecare nod model care participă la validare trebuie să poarte responsabilitatea pentru rezultate

Dacă intră frecvent în conflict cu judecățile altor noduri sau se detectează că se abate semnificativ de la traiectoria logică, își va pierde drepturile de validare și va pierde stimulente economice în rețea

Pentru ca verificarea să fie cu adevărat implementată, Mira a făcut o mulțime de optimizări inginerești la arhitectura de execuție

▪️ Cea mai critică este comprimarea rezultatului de validare într-un singur token

Această tehnologie de transformare a revendicărilor reduce dramatic costul per verificare, permițând sistemului să funcționeze în cazuri de utilizare la scară largă fără a încetini randamentul

▪️ La nivel de confidențialitate, validatorii Mira nu ating niciodată textul integral

Sistemul împarte automat conținutul și îl distribuie către diferite noduri pentru a asigura ireductibilitatea datelor în timpul procesului de verificare

În ultimul an, AI a fost împins în tot mai multe scenarii, iar viteza de generare s-a accelerat, dar mecanismul de verificare a stagnat practic

AI nu va fi trasă la răspundere, dar oamenii vor 😭

Deci rolul @MiraNetworkCN este de a opri AI-ul atunci când dă câteva lovituri oarbe

2,2K

Limită superioară

Clasament

Favorite