Trend-Themen

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

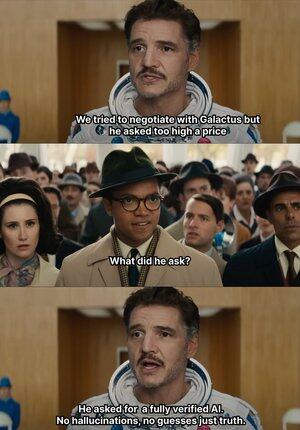

Wenn die KI anfängt, Unsinn zu erzählen, gibt @Mira_Network direkt einen Schlag 😂

Eine interessante Geschichte: Im Jahr 2023 reichte ein erfahrener Anwalt aus New York ein rechtliches Gutachten beim Bundesgericht ein.

Die Informationen schienen keine Mängel aufzuweisen, aber der Richter durchschaut es sofort; alle im Text aufgeführten Fälle existieren nicht, sie wurden alle von ChatGPT erfunden.

Seit 2023 ist OpenAI unser Hauptwerkzeug für Büroarbeit und Lernen geworden.

Davor musste ich normalerweise Informationen über Baidu und Google suchen, jetzt brauche ich nur noch GPT, um mir eine Zusammenfassung zu geben.

So hat sich eine Gewohnheit entwickelt: Man bekommt das Essen serviert und die Kleidung reicht man einfach, ich bin zu faul, um die Wahrheit zu überprüfen und benutze es direkt.

Die KI kann, selbst wenn sie Unsinn erzählt, niemanden über die Wahrheit täuschen, was viele Missverständnisse hervorrufen kann.

Denn solange die Sprache flüssig und die Logik anständig ist, kann sie die meisten Menschen täuschen.

Aber man kann nicht alles der KI zuschreiben; die Ausgaben der KI nehmen zu, aber die Fähigkeit zur Überprüfung stagniert fast, das Illusionsproblem wird zu einem strukturellen Risiko.

Gerade in diesem Kontext wird das Verifikationsnetzwerk von @Mira_Network zur Notwendigkeit.

@Mira_Network hat ein Verifikationsnetzwerk aufgebaut, das aus mehreren Modellen besteht, um das Problem der Selbstverifikation eines einzelnen Modells durch Kreuzprüfungen zwischen den Systemen zu beheben.

▪️ Der erste Schritt ist die Zerlegung der Aussagen.

Jede komplexe Ausgabe wird in eine Reihe grundlegenderer Behauptungen zerlegt.

Zum Beispiel: Die Erde dreht sich um die Sonne, der Mond dreht sich um die Erde, wird in zwei unabhängige Sätze zerlegt, die jeweils einzeln auf ihre Wahrheit überprüft werden können.

Anschließend werden mehrere Modelle in den Verifizierungsprozess eingebunden, jedes Modell gibt unabhängig eine Bewertung ab, das System zählt den Grad des Konsenses zwischen ihnen und bewertet die Vertrauenswürdigkeit.

Wenn der Konsens über dem Schwellenwert liegt, wird die Behauptung als gültig angesehen; wenn es erhebliche Meinungsverschiedenheiten gibt, wird eine zweite Überprüfung ausgelöst oder sie wird abgelehnt.

▪️ Daten aus den Testverifikationen von Mira zeigen:

> Der Konsensmechanismus von drei Modellen hat die Genauigkeit von 73,1 % auf 95,6 % erhöht.

> Die Gesamtfehlerquote ist um 84 % gesunken.

> Der durchschnittliche Konsistenzwert κ zwischen mehreren Modellen liegt nahe bei 0,8 und hat bereits eine stabile Urteilskraft.

Natürlich, wenn man nur mehrere Modelle abstimmen lässt, um die Wahrheit zu überprüfen, kann es leicht zu zufälligen Vermutungen kommen.

▪️ Der Grund, warum Mira funktionieren kann, ist, dass es einen Spielmechanismus in die Systemstruktur eingebaut hat.

Verifizierung ist kein kostenfreies Verhalten. Jedes Modell, das an der Verifizierung teilnimmt, muss die Verantwortung für die Ergebnisse übernehmen.

Wenn es häufig zu Konflikten mit anderen Knoten kommt oder deutlich von der logischen Spur abweicht, verliert es das Verifizierungsrecht und die wirtschaftlichen Anreize im Netzwerk.

Um die Verifizierung wirklich umzusetzen, hat Mira viele technische Optimierungen in der Ausführungsarchitektur vorgenommen.

▪️ Der entscheidendste Punkt ist: Die Verifizierungsausgaben werden in ein einzelnes Token komprimiert.

Diese Technik der Anspruchstransformation senkt die Kosten jeder Verifizierung erheblich, sodass das System in großflächigen Anwendungsszenarien betrieben werden kann, ohne die Durchsatzrate zu beeinträchtigen.

▪️ Auf der Datenschutzebene haben die Verifikationsknoten von Mira keinen Zugang zu vollständigen Texten.

Das System zerlegt automatisch den Inhalt und verteilt ihn an verschiedene Knoten, um die Unwiederherstellbarkeit der Daten während des Verifizierungsprozesses zu gewährleisten.

Im vergangenen Jahr wurde KI in immer mehr Szenarien eingesetzt, die Generierungsgeschwindigkeit hat zugenommen, aber die Verifizierungsmechanismen sind weitgehend stagnierend geblieben.

KI kann Unsinn erzählen, ohne zur Verantwortung gezogen zu werden, aber Menschen können das nicht 😭

Deshalb ist die Rolle von @MiraNetworkCN, wenn die KI Unsinn redet, einzugreifen und zu stoppen.

2,17K

Top

Ranking

Favoriten