Rubriques tendance

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

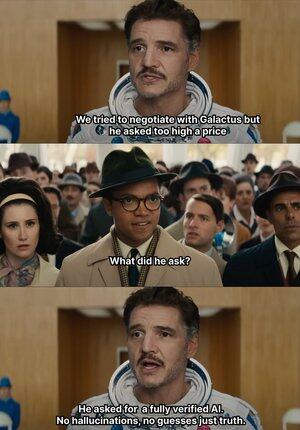

Quand l'IA commence à raconter n'importe quoi, @Mira_Network donne une claque directe 😂

Laissez-moi vous raconter quelque chose d'intéressant : en 2023, un avocat chevronné de New York a soumis un avis juridique à un tribunal fédéral.

Les documents semblaient sans faille, mais le juge a immédiatement vu à travers, tous les cas cités dans le texte n'existaient pas, c'était en fait des inventions de ChatGPT.

Depuis que OpenAI est devenu l'outil de génération principal pour notre travail et apprentissage en 2023.

Avant cela, je devais chercher des informations sur Baidu ou Google, maintenant il me suffit de demander à GPT de me résumer.

Avec le temps, cela est devenu une habitude, je me fais servir sans effort et je ne prends même plus la peine de vérifier la véracité, j'adopte directement.

L'IA, même si elle raconte n'importe quoi, personne ne sait ce qui est vrai ou faux, ce qui peut engendrer de nombreux incidents malheureux.

Car tant que le langage est fluide et que la logique est acceptable, elle peut tromper la grande majorité des gens.

Mais en réalité, ce genre de situation ne peut pas être entièrement attribué à l'IA, la production de l'IA augmente, mais la capacité de vérification est presque stagnante, le problème des hallucinations devient un risque structurel.

C'est dans ce contexte que le réseau de vérification des sorties d'IA de @Mira_Network devient une nécessité.

@Mira_Network établit un réseau de vérification composé de plusieurs modèles, utilisant des jugements croisés entre systèmes pour compenser l'incapacité d'un modèle unique à s'auto-vérifier.

▪️ La première étape consiste à décomposer les déclarations.

Toute sortie complexe sera décomposée en une série d'affirmations plus fondamentales.

Par exemple : la Terre tourne autour du Soleil, la Lune tourne autour de la Terre, cela sera décomposé en deux déclarations indépendantes, chacune pouvant être jugée séparément.

Ensuite, plusieurs modèles sont intégrés au processus de vérification, chaque modèle donne un jugement indépendant, le système va alors évaluer le degré de consensus entre eux et évaluer la confiance.

Si le consensus dépasse un seuil, cette affirmation est considérée comme valide ; si les divergences sont sévères, cela déclenche une vérification secondaire ou un rejet.

▪️ Les données provenant des tests de vérification de Mira montrent :

> Le mécanisme de consensus à trois modèles a augmenté la précision de 73,1 % à 95,6 %.

> Le taux d'erreur global a diminué de 84 %.

> La valeur de cohérence moyenne κ entre plusieurs modèles est proche de 0,8, montrant une capacité de jugement stable.

Bien sûr, si l'on se contente de faire voter plusieurs modèles pour juger de la véracité, il est facile d'obtenir des comportements de devinette aléatoire.

▪️ La raison pour laquelle Mira peut fonctionner est qu'elle a intégré un mécanisme de jeu dans la structure du système.

La vérification n'est pas une action sans coût. Chaque nœud de modèle participant à la vérification doit assumer la responsabilité des résultats.

S'il y a fréquemment des conflits de jugement avec d'autres nœuds, ou s'il est détecté qu'il s'écarte clairement de la logique, il perdra son droit de vérification et perdra les incitations économiques dans le réseau.

Pour que la vérification soit réellement mise en œuvre, Mira a effectué de nombreuses optimisations d'ingénierie dans son architecture d'exécution.

▪️ L'une des plus cruciales est : compresser la sortie de vérification en un seul token.

Cette technique de transformation de revendication réduit considérablement le coût de chaque vérification, permettant au système de fonctionner dans des scénarios d'application à grande échelle sans être submergé.

▪️ En ce qui concerne la confidentialité, les nœuds de vérification de Mira n'accèdent jamais au texte complet.

Le système divise automatiquement le contenu et le distribue à différents nœuds, garantissant l'irréversibilité des données pendant le processus de vérification.

Au cours de l'année passée, l'IA a été poussée dans de plus en plus de scénarios, la vitesse de génération s'accélère, mais le mécanisme de vérification est fondamentalement stagnant.

L'IA peut dire n'importe quoi sans être tenue responsable, mais les gens le seront 😭

Ainsi, le rôle de @MiraNetworkCN est d'intervenir lorsque l'IA commence à raconter n'importe quoi.

2,18K

Meilleurs

Classement

Favoris