Tópicos populares

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

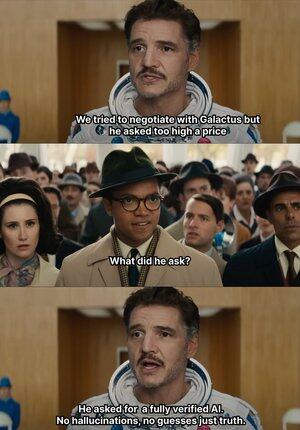

Quando a IA começa a inventar coisas, @Mira_Network dá um tapa direto 😂

Deixe-me contar algo interessante, em 2023, um advogado experiente de Nova Iorque apresentou uma opinião legal ao tribunal federal.

Os dados pareciam não ter falhas, mas foram imediatamente percebidos pelo juiz, todos os casos citados no texto não existiam, e ninguém esperava que fossem todos inventados pelo ChatGPT.

Desde que a OpenAI se tornou a ferramenta geradora principal para nosso trabalho e aprendizado em 2023.

Antes disso, eu costumava procurar informações no Baidu e no Google, agora só preciso que o GPT me resuma.

Com o tempo, isso se tornou um hábito, comida na boca e roupas na mão, e eu não me dou ao trabalho de verificar a veracidade, simplesmente uso.

A IA, mesmo inventando, ninguém sabe o que é verdade ou mentira, resultando em muitos incidentes confusos.

Porque, desde que a linguagem seja fluida e a lógica razoável, ela pode enganar a grande maioria das pessoas.

Mas, na verdade, essas coisas não podem ser totalmente atribuídas à IA, a saída da IA está aumentando, mas a capacidade de verificação praticamente estagnou, o problema da alucinação se tornou um risco estrutural.

É exatamente nesse contexto que a rede de verificação de saída da IA da @Mira_Network se tornou uma necessidade urgente.

A @Mira_Network estabelece uma rede de verificação composta por vários modelos, usando julgamentos cruzados entre sistemas para compensar a incapacidade de um único modelo se auto-verificar.

▪️ O primeiro passo é decompor a declaração.

Qualquer saída complexa será dividida em uma série de afirmações mais básicas.

Por exemplo: a Terra gira em torno do Sol, a Lua gira em torno da Terra, será decomposta em duas declarações independentes, cada uma podendo ser julgada separadamente quanto à veracidade.

Em seguida, vários modelos entram no processo de verificação, cada modelo dá seu julgamento de forma independente, o sistema contabiliza o grau de consenso entre eles e avalia o nível de confiança.

Se o consenso for superior ao limite, a afirmação é considerada válida; se houver divergências significativas, uma segunda verificação é acionada ou a afirmação é rejeitada.

▪️ Os dados dos testes de verificação da Mira mostram:

> O mecanismo de consenso de três modelos aumentou a precisão de 73,1% para 95,6%.

> A taxa de erro geral caiu 84%.

> O valor médio de consistência κ entre múltiplos modelos está próximo de 0,8, já demonstrando capacidade de julgamento estável.

Claro que, se apenas deixarmos vários modelos votarem sobre a veracidade, é fácil que comportamentos de adivinhação aleatória ocorram.

▪️ A razão pela qual a Mira pode operar é que ela incorporou um mecanismo de jogo na estrutura do sistema.

A verificação não é uma ação sem custo. Cada nó de modelo que participa da verificação precisa assumir a responsabilidade pelos resultados.

Se frequentemente houver conflitos de julgamento com outros nós, ou se for detectada uma clara divergência da lógica, perderá o direito de verificação e os incentivos econômicos na rede.

Para que a verificação realmente se concretize, a Mira fez uma grande quantidade de otimizações de engenharia na sua arquitetura de execução.

▪️ Um dos pontos mais críticos é: comprimir a saída de verificação em um único token.

Essa técnica de transformação de reivindicações reduz significativamente o custo de cada verificação, permitindo que o sistema funcione em cenários de aplicação em larga escala, sem sobrecarregar a capacidade de processamento.

▪️ Em termos de privacidade, os nós de verificação da Mira nunca acessam o texto completo.

O sistema automaticamente divide o conteúdo e distribui para diferentes nós, garantindo a irreversibilidade dos dados durante o processo de verificação.

No último ano, a IA foi levada a cada vez mais cenários, a velocidade de geração aumentou continuamente, mas o mecanismo de verificação basicamente estagnou.

A IA pode falar bobagens sem ser responsabilizada, mas as pessoas sim 😭

Portanto, o papel da @MiraNetworkCN é intervir quando a IA começa a falar besteira.

2,19K

Top

Classificação

Favoritos