Tópicos em alta

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

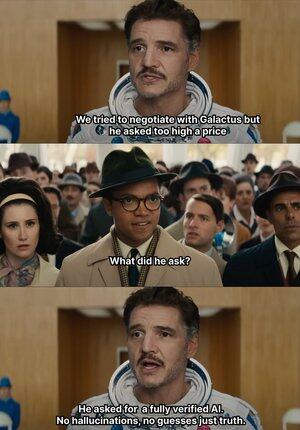

Quando a IA começa a fazer as pazes às cegas, @Mira_Network levanta diretamente a mão e dá um tapa 😂 nela

Em uma nota interessante, em 2023, um advogado sênior de Nova York apresentou um parecer jurídico ao tribunal federal

Os dados parecem não ter falhas, mas o juiz viu através deles de relance, e nenhum dos casos listados no artigo existia, mas eu não esperava que eles fossem fabricados pelo ChatGPT

A partir de 2023, a OpenAI tornou-se a principal ferramenta generativa para nosso aprendizado de escritório

Antes disso, eu geralmente tinha que procurar o Baidu e o Google para encontrar informações, mas agora só preciso do GPT para resumi-las

Dessa forma, desenvolvi o hábito de buscar comida e tenho preguiça de verificar a autenticidade e a adoção direta dela

Mesmo que a IA invente, ninguém sabe se é verdadeiro ou falso, muitos incidentes oolong nascerão

Porque, desde que a linguagem seja suave e lógica, ela pode enganar a grande maioria das pessoas

Mas, na verdade, esse tipo de coisa não pode depender inteiramente da IA, a IA produz cada vez mais, mas a capacidade de verificação está quase estagnada e o problema da alucinação se tornou um risco estrutural

É nesse contexto que a rede de verificação de saída de IA da @Mira_Network se tornou uma necessidade rígida

@Mira_Network Estabelecer uma rede de verificação composta por vários modelos e usar o julgamento cruzado entre os sistemas para compensar o problema de que um único modelo não pode se autocertificar

▪️ O primeiro passo é detalhar a declaração

Qualquer saída complexa é dividida em uma série de afirmações mais básicas

Por exemplo, a Terra gira em torno do Sol e a Lua gira em torno da Terra em duas afirmações independentes, cada uma das quais pode ser julgada separadamente como verdadeira ou falsa

Em seguida, vários modelos são conectados ao processo de verificação, e cada modelo emite julgamentos de forma independente, e o sistema contará o grau de consenso entre eles e avaliará o grau de confiança

Se o consenso estiver acima do limite, a reivindicação é considerada válida; Se o desacordo for sério, uma segunda verificação ou demissão é acionada

▪️ Os dados da validação do teste do Mira mostram:

> O mecanismo de consenso de três modelos melhora a precisão de 73,1% para 95,6%

> redução de 84% na taxa de erro geral

> O valor κ médio de consistência entre vários modelos é próximo de 0,8, que tem capacidade de julgamento estável

Claro, se você deixar vários modelos votarem para julgar a verdade, é fácil adivinhar aleatoriamente

▪️O Mira funciona porque incorpora a mecânica do jogo na estrutura do sistema

A validação não é um ato sem custo. Cada nó do modelo que participa da validação precisa assumir a responsabilidade pelos resultados

Se ele frequentemente entrar em conflito com os julgamentos de outros nós ou for detectado como um desvio significativo da trajetória lógica, ele perderá seus direitos de validação e perderá incentivos econômicos na rede

Para tornar a verificação realmente implementada, a Mira fez muitas otimizações de engenharia na arquitetura de execução

▪️ O mais crítico é compactar a saída de validação em um único token

Essa tecnologia de transformação de declarações reduz drasticamente o custo por verificação, permitindo que o sistema opere em casos de uso em larga escala sem diminuir a taxa de transferência

▪️ No nível de privacidade, os validadores da Mira nunca tocam no texto completo

O sistema divide automaticamente o conteúdo e o distribui para diferentes nós para garantir a irredutibilidade dos dados durante o processo de verificação

No ano passado, a IA foi empurrada para mais e mais cenários, e a velocidade de geração foi acelerando, mas o mecanismo de verificação basicamente estagnou

A IA não será responsabilizada, mas as pessoas serão 😭

Portanto, o papel de @MiraNetworkCN é parar a IA quando ela sopra alguns golpes cegos

2,2K

Melhores

Classificação

Favoritos