Temas en tendencia

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

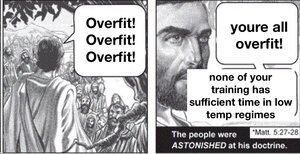

Si entrenas un modelo masivo y no lo regularizas de manera extremadamente rigurosa, se ajustará demasiado al dominio. La genialidad de los modelos de lenguaje es que si el dominio es todo el conocimiento humano que podemos escribir, hay muchas cosas dentro de la distribución para las que es útil.

Pero no hay razón para esperar que esto se generalice fuera de la distribución, particularmente. Así que los modelos de lenguaje, tal como están entrenados actualmente, siempre tendrán dificultades para lidiar con la expansión del conocimiento, a pesar de lo buenos que son para interpolar las lagunas.

El mundo no es estacionario, la distribución objetivo se desplaza con el tiempo. Así, los LLMs comienzan tan bien como siempre lo estarán, y lentamente empeoran con el tiempo. Por supuesto, obtendrán la misma puntuación en los antiguos benchmarks, pero se volverán sutilmente peores en todas las tareas del mundo real.

Puedes solucionar este problema hasta cierto punto incluyendo datos de múltiples períodos de tiempo y regularizando entre eras, pero en última instancia, eso solo enseñará al modelo cómo manejar las formas en que el mundo cambió en el pasado, que es un subconjunto de cómo cambiará en el futuro.

@joaoabrantis

9 ago, 23:00

Existen dos tipos de generalización en los sistemas de aprendizaje: estructural y dinámica. La generalización estructural implica consolidar dimensiones dispares en una única, y la generalización dinámica implica aprender a tomar acciones que permiten el aprendizaje en más entornos.

17.6K

Populares

Ranking

Favoritas