Rubriques tendance

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

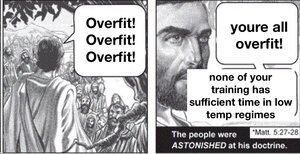

Si vous entraînez un modèle massif et que vous ne le régularisez pas de manière extrêmement stricte, il s'adaptera trop au domaine. Le génie des modèles de langage est que si le domaine est tout le savoir humain que nous pouvons écrire, il y a beaucoup de choses en distribution pour lesquelles il est utile.

Mais il n'y a aucune raison de s'attendre à ce que cela se généralise hors distribution, en particulier. Ainsi, les modèles de langage tels qu'ils sont actuellement entraînés auront toujours du mal à faire évoluer la frontière de la connaissance, malgré leur capacité à interpoler les lacunes.

Le monde est non stationnaire, la distribution cible dérive au fil du temps. Ainsi, les LLM commencent aussi bons qu'ils ne le seront jamais, et deviennent lentement moins performants avec le temps. Bien sûr, ils obtiendront les mêmes scores sur les anciens benchmarks, mais ils deviendront subtilement moins efficaces dans toutes les tâches du monde réel.

Vous pouvez résoudre ce problème dans une certaine mesure en incluant des données de plusieurs périodes et en régularisant entre les époques, mais en fin de compte, cela n'enseignera au modèle que comment gérer les façons dont le monde a changé dans le passé, ce qui n'est qu'un sous-ensemble de la façon dont il changera à l'avenir.

@joaoabrantis

9 août, 23:00

Il existe deux types de généralisation dans les systèmes d'apprentissage : structurelle et dynamique. La généralisation structurelle consiste à consolider des dimensions disparates en une seule, tandis que la généralisation dynamique implique d'apprendre à prendre des actions qui permettent d'apprendre dans des environnements plus variés.

18,22K

Meilleurs

Classement

Favoris