トレンドトピック

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

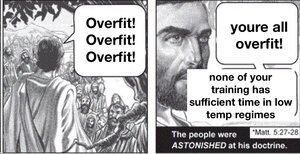

大規模なモデルをトレーニングし、極端に正則化しないと、ドメインに過剰適合してしまいます。言語モデルの天才性は、ドメインがすべて人間の知識であり、書き留めることができる場合、それが役立つ分布内のものがたくさんあるということです。

しかし、特にこれが流通から一般化されることを期待する理由はありません。したがって、現在トレーニングされている言語モデルは、ギャップを補間するのがどれほど得意であっても、知識のエッジを拡大することに対処するのに常に苦労します。

世界は非定常であり、ターゲット分布は時間とともにドリフトします。したがって、LLM はこれまでと同じように優れたものとしてスタートし、時間の経過とともに徐々に悪化します。ただし、古いベンチマークでも同じスコアを獲得しますが、現実世界のすべてのタスクで微妙に悪くなります。

この問題は、複数の期間のデータを含め、時代間を正規化することである程度修正できますが、最終的には、世界が過去にどのように変化するかを処理する方法をモデルに教えるだけです。

@joaoabrantis

8月9日 23:00

学習システムには、構造的一般化と動的一般化の2種類があります。構造的一般化には、異種の次元を単一の次元に統合することが含まれ、動的一般化には、より多くの環境での学習を可能にする行動を実行することを学習することが含まれます。

18.42K

トップ

ランキング

お気に入り