Tópicos populares

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

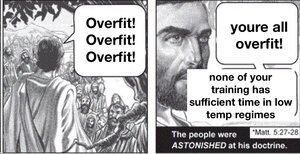

Se você treinar um modelo massivo e não o regularizar de forma extremamente rigorosa, ele irá se ajustar excessivamente ao domínio. O gênio dos modelos de linguagem é que, se o domínio é todo o conhecimento humano que podemos escrever, há muitas coisas dentro da distribuição para as quais ele é útil.

Mas não há razão para esperar que isso se generalize fora da distribuição, particularmente. Assim, os modelos de linguagem, como estão atualmente treinados, sempre terão dificuldades em lidar com a expansão da fronteira do conhecimento, apesar de quão bons eles são em interpolar as lacunas.

O mundo é não estacionário, a distribuição alvo muda ao longo do tempo. Assim, os LLMs começam tão bons quanto jamais serão, e lentamente pioram ao longo do tempo. Claro que eles vão ter as mesmas pontuações nos antigos benchmarks, mas vão ficar sutilmente piores em todas as tarefas do mundo real.

Você pode corrigir esse problema até certo ponto incluindo dados de múltiplos períodos de tempo e regularizando entre as eras, mas, em última análise, isso apenas ensinará ao modelo como lidar com as maneiras como o mundo mudou no passado, que é um subconjunto de como ele mudará no futuro.

@joaoabrantis

9/08, 23:00

Existem dois tipos de generalização em sistemas de aprendizagem: estrutural e dinâmica. A generalização estrutural envolve consolidar dimensões díspares em uma única, e a generalização dinâmica envolve aprender a tomar ações que possibilitem a aprendizagem em mais ambientes.

18,22K

Top

Classificação

Favoritos