Trend-Themen

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

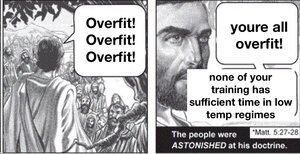

Wenn Sie ein massives Modell trainieren und es nicht extrem stark regularisieren, wird es sich an die Domäne anpassen. Das Genie der Sprachmodelle besteht darin, dass, wenn die Domäne das gesamte menschliche Wissen ist, das wir aufschreiben können, es viele in-Distribution-Dinge gibt, für die es nützlich ist.

Aber es gibt keinen Grund zu erwarten, dass sich dies besonders auf andere Verteilungen verallgemeinern lässt. Daher werden Sprachmodelle, wie sie derzeit trainiert werden, immer Schwierigkeiten haben, die Grenzen des Wissens zu erweitern, egal wie gut sie darin sind, die Lücken zu interpolieren.

Die Welt ist nicht stationär, die Zielverteilung driftet im Laufe der Zeit. Daher sind LLMs zu Beginn so gut, wie sie jemals sein werden, und werden im Laufe der Zeit langsam schlechter. Natürlich werden sie bei den alten Benchmarks gleich abschneiden, aber sie werden bei allen realen Aufgaben subtil schlechter.

Sie können dieses Problem bis zu einem gewissen Grad beheben, indem Sie Daten aus mehreren Zeiträumen einbeziehen und zwischen den Epochen regulieren, aber letztendlich wird das nur dem Modell beibringen, wie es mit den Veränderungen in der Vergangenheit umgeht, was nur ein Teil davon ist, wie es sich in der Zukunft verändern wird.

@joaoabrantis

9. Aug., 23:00

Es gibt zwei Arten von Verallgemeinerungen in Lernsystemen: strukturell und dynamisch. Strukturelle Verallgemeinerung beinhaltet die Konsolidierung unterschiedlicher Dimensionen zu einer einzigen, und dynamische Verallgemeinerung beinhaltet das Lernen, Maßnahmen zu ergreifen, die das Lernen in mehr Umgebungen ermöglichen.

17,6K

Top

Ranking

Favoriten