Актуальні теми

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

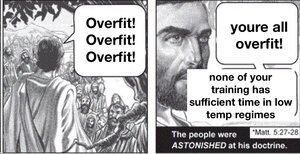

Якщо ви тренуєте масивну модель і не регулярите її дуже інтенсивно, вона перепідігнатиметься під себе. Геніальність мовних моделей полягає в тому, що якщо предметом є всі людські знання, які ми можемо записати, то є багато речей, для яких вони корисні.

Але немає підстав очікувати, що це буде узагальнено поза розподілом, зокрема. Таким чином, мовні моделі, в тому вигляді, в якому вони навчаються зараз, завжди будуть боротися зі зростанням межі знань, незважаючи на те, наскільки добре вони вміють інтерполювати прогалини.

Світ нестаціонарний, цільовий розподіл дрейфує в часі. Таким чином, LLM починаються так само добре, як і коли-небудь, і поступово погіршуються з часом. Ofc вони отримають ті ж результати на старих тестах, але вони стануть непомітно гіршими у всіх реальних завданнях.

Ви можете певною мірою вирішити цю проблему, включивши дані з кількох періодів часу та впорядкувавши між епохами, але в кінцевому підсумку це лише навчить модель справлятися з тим, як світ змінювався в минулому, що є підмножиною того, як він зміниться в майбутньому.

@joaoabrantis

9 серп., 23:00

У системах навчання розрізняють два види узагальнення: структурне і динамічне. Структурне узагальнення передбачає об'єднання розрізнених вимірів в одиничний, а динамічне узагальнення передбачає навчання діям, які дозволяють навчатися в більшій кількості середовищ.

17,59K

Найкращі

Рейтинг

Вибране