Rubriques tendance

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

Alex Volkov (Thursd/AI)

✌️ Codeur Vibe

🎙️ Animateur de @thursdai_pod

✨ Évangéliste IA avec @weights_biases 🪄🐝

Travailler sur @weave_wb (opinions personnelles)

C'est vivant ! La dernière baleine est en train d'inférer dans W&B 👏

2963E622 août, 08:02

GRANDE LANCEMENT : La V3.1 de @deepseek_ai est maintenant en ligne sur W&B Inference !

Un modèle, deux modes : basculez entre le mode 'Non-Pensée' à grande vitesse et le mode 'Pensée' approfondie.

Prix de seulement 0,55 $/1,65 $ par 1M de tokens, c’est un véritable changement de jeu pour la création d'agents intelligents.

Vous voulez 50 $ de crédits gratuits ? Détails ci-dessous.

3,56K

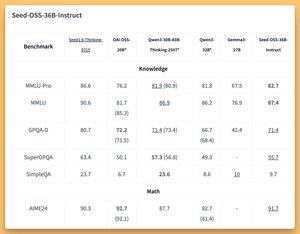

Quelqu'un a-t-il essayé ce LLM agentique à long contexte de ByteDance ? 👀

Ou est-ce que l'engouement autour des modèles chinois open source est en baisse ?

Modèles Instruct et Based de 36B (même de base sans données synthétiques) avec d'excellents bancs (SOTA ?) 🤔

Nous allons en parler demain sur @thursdai_pod.

𝚐𝔪𝟾𝚡𝚡𝟾21 août, 04:02

ByteDance publie Seed-OSS (Apache-2.0) : série LLM ouverte (12T tokens) optimisée pour 512K ctx, raisonnement, tâches d'agent, i18n (utilisation internationale). La publication inclut Seed-OSS-36B-Base (avec et sans données synthétiques) et Seed-OSS-36B-Instruct

- Architecture : 36B params, 64L, caché 5120, vocab 155K, GQA (80/8/8, tête 128), SwiGLU, RMSNorm, RoPE base 1e7

- Budget de réflexion : Contrôler la longueur du raisonnement (multiples de 512), auto-réflexion CoT, 0 = réponses directes, par défaut = illimité

36B-Base (avec vs sans syn.)

- MMLU-Pro 65.1 / 60.4 | MMLU 84.9 / 84.8 | TriviaQA 82.1 / 81.9 | GPQA-D 31.7 / 35.2

- BBH 87.7 / 87.2 | AGIEval-en 70.7 / 70.1

- GSM8K 90.8 / 90.3 | MATH 81.7 SOTA / 61.3

- MBPP 80.6 / 74.6 | HumanEval 76.8 / 75.6

36B-Instruct

- MMLU-Pro 82.7 | MMLU 87.4 | GPQA-D 71.4 | SuperGPQA 55.7

- AIME24 91.7 SOTA | AIME25 84.7 | BeyondAIME 65

- ArcAGI V2 40.6 | KORBench 70.6

- LiveCodeBench v6 67.4 SOTA | HLE 10.1

- IFEval 85.8 | TAU1-Retail 70.4 SOTA | TAU1-Airline 46

- SWE-Bench Vérifié 56 SOTA | Multi-SWE-Bench 17

- MMMLU 78.4 | RULER (128K) 94.6 SOTA | AIR-Bench 75.6

Inférence : Transformers, vLLM (≥0.10.0), FlashAttention2, quantification 4/8 bits

3,1K

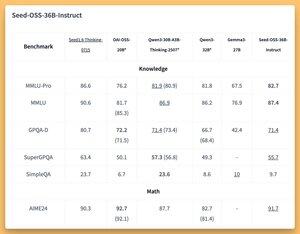

Quelqu'un a-t-il essayé ce LLM de penseur agentique de ByteDance ? 👀

Ou est-ce que l'engouement autour des modèles chinois open source est en baisse ?

Modèles Instruct et Based de 36B (même de base sans données synthétiques) avec d'excellentes performances (SOTA ?) 🤔

Nous allons en parler demain sur @thursdai_pod.

𝚐𝔪𝟾𝚡𝚡𝟾21 août, 04:02

ByteDance publie Seed-OSS (Apache-2.0) : série LLM ouverte (12T tokens) optimisée pour 512K ctx, raisonnement, tâches d'agent, i18n (utilisation internationale). La publication inclut Seed-OSS-36B-Base (avec et sans données synthétiques) et Seed-OSS-36B-Instruct

- Architecture : 36B params, 64L, caché 5120, vocab 155K, GQA (80/8/8, tête 128), SwiGLU, RMSNorm, RoPE base 1e7

- Budget de réflexion : Contrôler la longueur du raisonnement (multiples de 512), auto-réflexion CoT, 0 = réponses directes, par défaut = illimité

36B-Base (avec vs sans syn.)

- MMLU-Pro 65.1 / 60.4 | MMLU 84.9 / 84.8 | TriviaQA 82.1 / 81.9 | GPQA-D 31.7 / 35.2

- BBH 87.7 / 87.2 | AGIEval-en 70.7 / 70.1

- GSM8K 90.8 / 90.3 | MATH 81.7 SOTA / 61.3

- MBPP 80.6 / 74.6 | HumanEval 76.8 / 75.6

36B-Instruct

- MMLU-Pro 82.7 | MMLU 87.4 | GPQA-D 71.4 | SuperGPQA 55.7

- AIME24 91.7 SOTA | AIME25 84.7 | BeyondAIME 65

- ArcAGI V2 40.6 | KORBench 70.6

- LiveCodeBench v6 67.4 SOTA | HLE 10.1

- IFEval 85.8 | TAU1-Retail 70.4 SOTA | TAU1-Airline 46

- SWE-Bench Vérifié 56 SOTA | Multi-SWE-Bench 17

- MMMLU 78.4 | RULER (128K) 94.6 SOTA | AIR-Bench 75.6

Inférence : Transformers, vLLM (≥0.10.0), FlashAttention2, quantification 4/8 bits

180

Honnêtement !

J'ai passé une semaine en Europe pendant l'été, à cause de X j'ai d'abord ri de cela, puis je suis revenu et j'ai réalisé à quel point c'est génial et nous devons l'adopter partout.

Tomasz Łakomy21 août, 04:27

Mon avis le plus audacieux est que ce sont d'excellentes idées et qu'elles devraient être adoptées partout.

3,27K

Venez goûter un peu d'herbe à chat 🐱

Lukas Biewald20 août, 02:22

Mon cofondateur @vanpelt a créé un nouveau produit open source appelé catnip. Il facilite l'exécution de @claude_code sur votre projet dans de nombreux conteneurs docker parallèles en même temps. Il gère le transfert de port de manière très efficace. Je l'utilise depuis quelques semaines et j'adore.

1,49K

Alex Volkov (Thursd/AI) a reposté

W&B édition Win95

Vous pouvez maintenant enregistrer des HTML interactifs dans W&B Weave et les voir rendus dans les traces.

J'ai profité de cette occasion pour utiliser le codeur Qwen3 sur W&B Inference afin de générer une édition W&B Win95.

Pour commencer, il suffit d'annoter votre fonction de génération et elle sera enregistrée en tant que HTML.

1,14K

Alex Volkov (Thursd/AI) a reposté

🚀 Nouveau dans Weave : API de contenu

Enregistrez tout média utilisé par vos applications IA et analysez-le dans des traces. Inspectez, évaluez et comparez des images, de l'audio, des vidéos, du markdown, des PDF et même du HTML.

Fonctionne avec tous vos agents et applications IA. Un seul endroit pour tous vos besoins de débogage multimodal.

1,9K

Meilleurs

Classement

Favoris

Tendance on-chain

Tendance sur X

Récents financements de premier plan

Les plus notables