Popularne tematy

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

Alex Volkov (Thursd/AI)

✌️ Vibe Coder

🎙️ Gospodarz @thursdai_pod

✨ Ewangelista AI z @weights_biases 🪄🐝

praca nad @weave_wb (opinie własne)

To żyje! Najnowszy wieloryb jest aktywny w W&B inference 👏

2963E622 sie, 08:02

WIELKIE URUCHOMIENIE: Wersja 3.1 @deepseek_ai jest już dostępna na W&B Inference!

Jeden model, dwa tryby: przełączaj się między szybkim 'Non-Think' a głębokim 'Think'.

Cena wynosi zaledwie 0,55 USD/1,65 USD za 1M tokenów, to prawdziwa rewolucja w budowaniu inteligentnych agentów.

Chcesz 50 USD w darmowych kredytach? Szczegóły poniżej.

3,56K

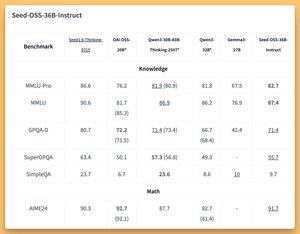

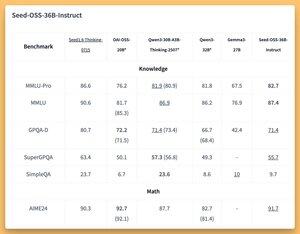

Czy ktoś próbował tego agentycznego modelu LLM z długim kontekstem od ByteDance? 👀

Czy hype wokół otwartych modeli chińskich opadł?

Modele 36B Instruct i Based (nawet bazowe bez danych syntetycznych) z świetnymi (SOTA?) wynikami 🤔

Jutro omówimy to w @thursdai_pod

𝚐𝔪𝟾𝚡𝚡𝟾21 sie, 04:02

ByteDance wydaje Seed-OSS (Apache-2.0): otwarta seria LLM (12T tokenów) zoptymalizowana dla 512K kontekstu, rozumowania, zadań agenta, i18n (międzynarodowe użycie). Wydanie obejmuje Seed-OSS-36B-Base (z danymi syntetycznymi i bez) oraz Seed-OSS-36B-Instruct

- Arch: 36B parametrów, 64L, ukryty 5120, słownik 155K, GQA (80/8/8, głowa 128), SwiGLU, RMSNorm, RoPE baza 1e7

- Budżet myślenia: Kontrola długości rozumowania (wielokrotności 512), CoT samorefleksja, 0 = bezpośrednie odpowiedzi, domyślnie = nieograniczone

36B-Base (z vs bez syn.)

- MMLU-Pro 65.1 / 60.4 | MMLU 84.9 / 84.8 | TriviaQA 82.1 / 81.9 | GPQA-D 31.7 / 35.2

- BBH 87.7 / 87.2 | AGIEval-en 70.7 / 70.1

- GSM8K 90.8 / 90.3 | MATH 81.7 SOTA / 61.3

- MBPP 80.6 / 74.6 | HumanEval 76.8 / 75.6

36B-Instruct

- MMLU-Pro 82.7 | MMLU 87.4 | GPQA-D 71.4 | SuperGPQA 55.7

- AIME24 91.7 SOTA | AIME25 84.7 | BeyondAIME 65

- ArcAGI V2 40.6 | KORBench 70.6

- LiveCodeBench v6 67.4 SOTA | HLE 10.1

- IFEval 85.8 | TAU1-Retail 70.4 SOTA | TAU1-Airline 46

- SWE-Bench Zweryfikowane 56 SOTA | Multi-SWE-Bench 17

- MMMLU 78.4 | RULER (128K) 94.6 SOTA | AIR-Bench 75.6

Wnioskowanie: Transformers, vLLM (≥0.10.0), FlashAttention2, kwantyzacja 4/8-bitowa

3,1K

Czy ktoś próbował tego agentycznego myśliciela LLM od ByteDance? 👀

Czy hype wokół otwartych modeli chińskich opadł?

Modele 36B Instruct i Based (nawet bazowe bez danych syntetycznych) z świetnymi (SOTA?) wynikami 🤔

Jutro omówimy to w @thursdai_pod

𝚐𝔪𝟾𝚡𝚡𝟾21 sie, 04:02

ByteDance wydaje Seed-OSS (Apache-2.0): otwarta seria LLM (12T tokenów) zoptymalizowana dla 512K kontekstu, rozumowania, zadań agenta, i18n (międzynarodowe użycie). Wydanie obejmuje Seed-OSS-36B-Base (z danymi syntetycznymi i bez) oraz Seed-OSS-36B-Instruct

- Arch: 36B parametrów, 64L, ukryty 5120, słownik 155K, GQA (80/8/8, głowa 128), SwiGLU, RMSNorm, RoPE baza 1e7

- Budżet myślenia: Kontrola długości rozumowania (wielokrotności 512), CoT samorefleksja, 0 = bezpośrednie odpowiedzi, domyślnie = nieograniczone

36B-Base (z vs bez syn.)

- MMLU-Pro 65.1 / 60.4 | MMLU 84.9 / 84.8 | TriviaQA 82.1 / 81.9 | GPQA-D 31.7 / 35.2

- BBH 87.7 / 87.2 | AGIEval-en 70.7 / 70.1

- GSM8K 90.8 / 90.3 | MATH 81.7 SOTA / 61.3

- MBPP 80.6 / 74.6 | HumanEval 76.8 / 75.6

36B-Instruct

- MMLU-Pro 82.7 | MMLU 87.4 | GPQA-D 71.4 | SuperGPQA 55.7

- AIME24 91.7 SOTA | AIME25 84.7 | BeyondAIME 65

- ArcAGI V2 40.6 | KORBench 70.6

- LiveCodeBench v6 67.4 SOTA | HLE 10.1

- IFEval 85.8 | TAU1-Retail 70.4 SOTA | TAU1-Airline 46

- SWE-Bench Zweryfikowane 56 SOTA | Multi-SWE-Bench 17

- MMMLU 78.4 | RULER (128K) 94.6 SOTA | AIR-Bench 75.6

Wnioskowanie: Transformers, vLLM (≥0.10.0), FlashAttention2, kwantyzacja 4/8-bitowa

182

Szczerze!

Spędziłem tydzień w Europie latem, ponieważ przez X na początku się z tego śmiałem, a potem wróciłem i zdałem sobie sprawę, jak genialne to jest i musimy to przyjąć wszędzie.

Tomasz Łakomy21 sie, 04:27

Moim najgorętszym zdaniem jest to, że te rzeczy są świetne i powinny być przyjęte wszędzie.

3,27K

Spróbuj trochę kocimiętki 🐱

Lukas Biewald20 sie, 02:22

Mój współzałożyciel @vanpelt stworzył nowy produkt open source o nazwie catnip. Ułatwia uruchamianie @claude_code w Twoim projekcie w wielu równoległych kontenerach docker jednocześnie. Świetnie radzi sobie z przekazywaniem portów. Używam go od kilku tygodni i bardzo mi się podoba.

1,49K

Użytkownik Alex Volkov (Thursd/AI) udostępnił ponownie

W&B Win95 edycja

Możesz teraz rejestrować interaktywny HTML w W&B Weave i zobaczyć go renderowanego w śladach.

Skorzystałem z tej okazji, aby użyć kodera Qwen3 na W&B Inference, aby wygenerować edycję W&B Win95.

Aby rozpocząć, wystarczy oznaczyć swoją funkcję generującą, a zostanie ona zarejestrowana jako HTML.

1,14K

Użytkownik Alex Volkov (Thursd/AI) udostępnił ponownie

🚀 Nowość w Weave: API treści

Rejestruj wszelkie media, które wykorzystują Twoje aplikacje AI i analizuj je w śladach. Inspekcja, ocena i porównywanie obrazów, dźwięku, wideo, markdown, PDF-ów, a nawet HTML.

Działa we wszystkich Twoich agentach i aplikacjach AI. Jedno miejsce na wszystkie Twoje potrzeby związane z debugowaniem multimodalnym.

1,9K

Najlepsze

Ranking

Ulubione

Trendy onchain

Trendy na X

Niedawne największe finansowanie

Najbardziej godne uwagi