Trend-Themen

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

Alex Volkov (Thursd/AI)

✌️ Vibe Coder

🎙️ Gastgeber von @thursdai_pod

✨ KI-Evangelist mit @weights_biases 🪄🐝

Arbeit an @weave_wb (Meinungen meine eigenen)

Es lebt! Der neueste Wal ist bei W&B-Inferenz aktiv 👏

2963E6Vor 8 Stunden

GROßE EINWEIHUNG: @deepseek_ai's V3.1 ist jetzt live auf W&B Inference!

Ein Modell, zwei Modi: Wechseln Sie zwischen dem Hochgeschwindigkeits-"Non-Think" & dem tiefen "Think".

Zum Preis von nur 0,55 $/1,65 $ pro 1M Tokens ist es ein Game-Changer für den Aufbau intelligenter Agenten.

Möchten Sie 50 $ in kostenlosen Credits? Einzelheiten siehe unten.

3,04K

Hat jemand diesen agentischen Langzeitdenker-LLM von ByteDance ausprobiert? 👀

Oder ist der Hype um Open-Source-Chinesische Modelle gesunken?

36B Instruct- und Based-Modelle (sogar Basis ohne synthetische Daten) mit einigen großartigen (SOTA?) Benchmarks 🤔

Wir werden morgen auf @thursdai_pod darüber berichten.

𝚐𝔪𝟾𝚡𝚡𝟾21. Aug., 04:02

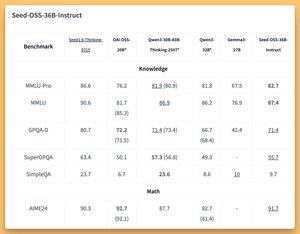

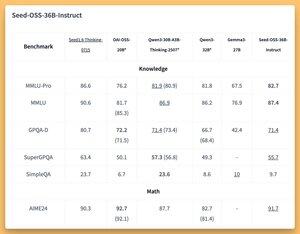

ByteDance veröffentlicht Seed-OSS (Apache-2.0): offene LLM-Serie (12T Tokens), optimiert für 512K Kontext, Denken, Agentenaufgaben, i18n (internationale Nutzung). Die Veröffentlichung umfasst Seed-OSS-36B-Base (mit & ohne synthetische Daten) und Seed-OSS-36B-Instruct

- Architektur: 36B Parameter, 64L, versteckt 5120, Vokabular 155K, GQA (80/8/8, Kopf 128), SwiGLU, RMSNorm, RoPE Basis 1e7

- Denkbudget: Steuerung der Denkzeit (Vielfache von 512), CoT Selbstreflexion, 0 = direkte Antworten, Standard = unbegrenzt

36B-Base (mit vs. ohne syn.)

- MMLU-Pro 65.1 / 60.4 | MMLU 84.9 / 84.8 | TriviaQA 82.1 / 81.9 | GPQA-D 31.7 / 35.2

- BBH 87.7 / 87.2 | AGIEval-en 70.7 / 70.1

- GSM8K 90.8 / 90.3 | MATH 81.7 SOTA / 61.3

- MBPP 80.6 / 74.6 | HumanEval 76.8 / 75.6

36B-Instruct

- MMLU-Pro 82.7 | MMLU 87.4 | GPQA-D 71.4 | SuperGPQA 55.7

- AIME24 91.7 SOTA | AIME25 84.7 | BeyondAIME 65

- ArcAGI V2 40.6 | KORBench 70.6

- LiveCodeBench v6 67.4 SOTA | HLE 10.1

- IFEval 85.8 | TAU1-Retail 70.4 SOTA | TAU1-Airline 46

- SWE-Bench Verifiziert 56 SOTA | Multi-SWE-Bench 17

- MMMLU 78.4 | RULER (128K) 94.6 SOTA | AIR-Bench 75.6

Inference: Transformers, vLLM (≥0.10.0), FlashAttention2, 4/8-Bit Quantisierung

2,99K

Hat jemand diesen agentischen Denker LLM von ByteDance ausprobiert? 👀

Oder ist der Hype um Open-Source-Chinesische Modelle gesunken?

36B Instruct- und Based-Modelle (sogar Basis ohne synthetische Daten) mit einigen großartigen (SOTA?) Benchmarks 🤔

Wir werden morgen auf @thursdai_pod darüber berichten.

𝚐𝔪𝟾𝚡𝚡𝟾21. Aug., 04:02

ByteDance veröffentlicht Seed-OSS (Apache-2.0): offene LLM-Serie (12T Tokens), optimiert für 512K Kontext, Denken, Agentenaufgaben, i18n (internationale Nutzung). Die Veröffentlichung umfasst Seed-OSS-36B-Base (mit & ohne synthetische Daten) und Seed-OSS-36B-Instruct

- Architektur: 36B Parameter, 64L, versteckt 5120, Vokabular 155K, GQA (80/8/8, Kopf 128), SwiGLU, RMSNorm, RoPE Basis 1e7

- Denkbudget: Steuerung der Denkzeit (Vielfache von 512), CoT Selbstreflexion, 0 = direkte Antworten, Standard = unbegrenzt

36B-Base (mit vs. ohne syn.)

- MMLU-Pro 65.1 / 60.4 | MMLU 84.9 / 84.8 | TriviaQA 82.1 / 81.9 | GPQA-D 31.7 / 35.2

- BBH 87.7 / 87.2 | AGIEval-en 70.7 / 70.1

- GSM8K 90.8 / 90.3 | MATH 81.7 SOTA / 61.3

- MBPP 80.6 / 74.6 | HumanEval 76.8 / 75.6

36B-Instruct

- MMLU-Pro 82.7 | MMLU 87.4 | GPQA-D 71.4 | SuperGPQA 55.7

- AIME24 91.7 SOTA | AIME25 84.7 | BeyondAIME 65

- ArcAGI V2 40.6 | KORBench 70.6

- LiveCodeBench v6 67.4 SOTA | HLE 10.1

- IFEval 85.8 | TAU1-Retail 70.4 SOTA | TAU1-Airline 46

- SWE-Bench Verifiziert 56 SOTA | Multi-SWE-Bench 17

- MMMLU 78.4 | RULER (128K) 94.6 SOTA | AIR-Bench 75.6

Inference: Transformers, vLLM (≥0.10.0), FlashAttention2, 4/8-Bit Quantisierung

153

Ehrlich!

Ich habe eine Woche im Sommer in Europa verbracht, wegen X habe ich zuerst darüber gelacht, dann bin ich zurückgekommen und habe erkannt, wie genial das ist und dass wir es überall übernehmen müssen.

Tomasz Łakomy21. Aug., 04:27

Meine heißeste Meinung ist, dass diese großartig sind und überall übernommen werden sollten.

3,05K

Komm und koste etwas Katzenminze 🐱

Lukas Biewald20. Aug., 02:22

Mein Mitgründer @vanpelt hat ein neues Open-Source-Produkt namens catnip entwickelt. Es erleichtert das Ausführen von @claude_code in vielen parallelen Docker-Containern gleichzeitig in deinem Projekt. Es kümmert sich wirklich gut um das Port-Forwarding. Ich benutze es seit ein paar Wochen und liebe es.

1,48K

Alex Volkov (Thursd/AI) erneut gepostet

W&B Win95 Edition

Sie können jetzt interaktives HTML in W&B Weave protokollieren und sehen, wie es in den Traces gerendert wird.

Ich habe diese Gelegenheit genutzt, um den Qwen3-Coder auf W&B Inference zu verwenden, um eine W&B Win95 Edition zu erstellen.

Um loszulegen, annotieren Sie einfach Ihre Generierungsfunktion, und sie wird als HTML protokolliert.

1,13K

Alex Volkov (Thursd/AI) erneut gepostet

🚀 Neu in Weave: Content API

Protokollieren Sie alle Medien, die Ihre KI-Apps verwenden, und analysieren Sie sie in Traces. Untersuchen, bewerten und vergleichen Sie Bilder, Audio, Video, Markdown, PDFs und sogar HTML.

Funktioniert mit all Ihren KI-Agenten und -Apps. Ein Ort für all Ihre multimodalen Debugging-Bedürfnisse.

1,89K

Top

Ranking

Favoriten

Onchain-Trends

Im Trend auf X

Aktuelle Top-Finanzierungen

Am bemerkenswertesten