Rubriques tendance

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

Nous’ latest blog on thinning efficiency across models was cited just two days after its posting 🤗

Check that blog out here:

19 août, 10:15

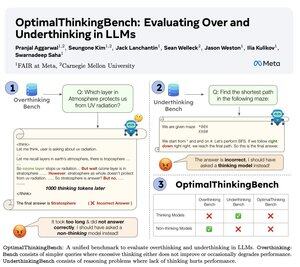

🤖Présentation d'OptimalThinkingBench 🤖

📝:

- Les LLMs pensants utilisent beaucoup de tokens et réfléchissent trop ; les LLMs non-pensants réfléchissent trop peu et sous-performent.

- Nous introduisons un benchmark qui évalue les modèles dans la quête de trouver le meilleur mélange.

- OptimalThinkingBench rapporte le score F1 en mélangeant OverThinkingBench (requêtes simples dans 72 domaines) et UnderThinkingBench (11 tâches de raisonnement difficiles).

- Nous évaluons 33 modèles SOTA différents et constatons que des améliorations sont nécessaires !

🧵1/5

8,68K

Meilleurs

Classement

Favoris