Subiecte populare

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

Cel mai recent blog al lui Nous despre eficiența subțierii pe modele a fost citat la doar două zile după postare 🤗

Verificați acel blog aici:

19 aug., 10:15

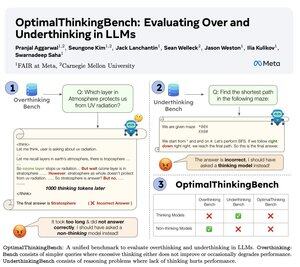

🤖Vă prezentăm OptimalThinkingBench 🤖

📝:

- LLM-urile gânditoare folosesc o mulțime de jetoane și gândesc prea mult; LLM-urile negânditoare nu gândesc și nu au performanțe.

- Introducem un benchmark care punctează modelele în încercarea de a găsi cel mai bun amestec.

- OptimalThinkingBench raportează scorul F1 amestecând OverThinkingBench (interogări simple în 72 de domenii) și UnderThinkingBench (11 sarcini de raționament provocatoare).

- Evaluăm 33 de modele SOTA diferite și găsim că sunt necesare îmbunătățiri!

🧵1/5

8,69K

Limită superioară

Clasament

Favorite