熱門話題

#

Bonk 生態迷因幣展現強韌勢頭

#

有消息稱 Pump.fun 計劃 40 億估值發幣,引發市場猜測

#

Solana 新代幣發射平臺 Boop.Fun 風頭正勁

我們最新的博客關於各模型的稀疏效率在發布後僅兩天就被引用了🤗

在這裡查看該博客:

8月19日 10:15

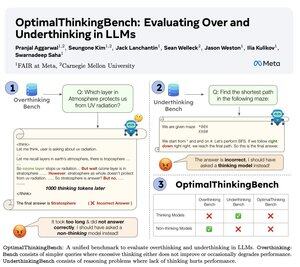

🤖介紹 OptimalThinkingBench 🤖

📝:

- 思考型 LLM 使用大量的 tokens 並且過度思考;非思考型 LLM 則思考不足且表現不佳。

- 我們引入了一個基準,評分模型以尋找最佳組合。

- OptimalThinkingBench 報告了 F1 分數,結合了 OverThinkingBench(72 個領域的簡單查詢)和 UnderThinkingBench(11 個具有挑戰性的推理任務)。

- 我們評估了 33 種不同的 SOTA 模型,發現需要改進!

🧵1/5

8.63K

熱門

排行

收藏