Trendaavat aiheet

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

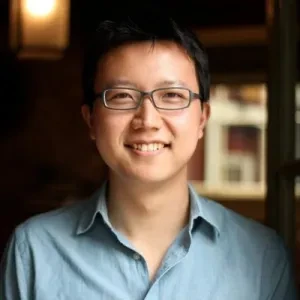

Peter Yang

Jaan erittäin käytännöllisiä tekoälyn tutoriaaleja ja haastatteluja | Liity 140K+ lukijoiden joukkoon osoitteessa https://t.co/XYKTmGVH14 | Tuote Robloxissa

Johtavat

Rankkaus

Suosikit