Argomenti di tendenza

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

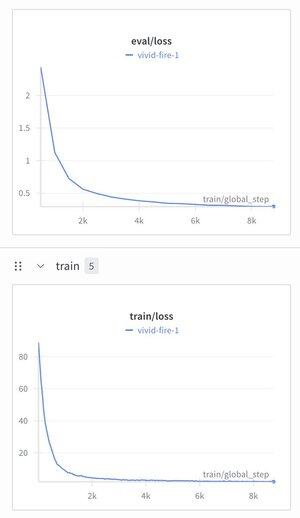

Ho deciso di prendere il Modello di Ragionamento Gerarchico e applicarci un tokenizer di testo giusto per vedere cosa succede.

L'ho addestrato su un dataset di tuning delle istruzioni (Alpaca), sono rimasto stupito di vedere la perdita scendere a ~1.9.

Produce ancora spazzatura ben strutturata, ha probabilmente bisogno di pre-addestramento, ma se funziona è piuttosto importante...

270

Principali

Ranking

Preferiti