Trend-Themen

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

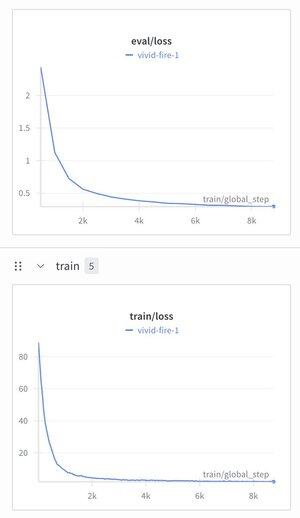

Ich habe mich entschieden, das Hierarchical Reasoning Model zu nehmen und einen Text-Tokenizer darauf anzuwenden, nur um zu sehen, was passieren würde.

Ich habe es mit einem Instruction-Tuning-Datensatz (Alpaca) trainiert und war erstaunt zu sehen, dass der Verlust auf ~1,9 gesunken ist.

Es produziert momentan immer noch gut strukturierten Müll, braucht wahrscheinlich ein Pre-Training, aber das ist ziemlich groß, wenn es funktioniert...

269

Top

Ranking

Favoriten