Popularne tematy

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

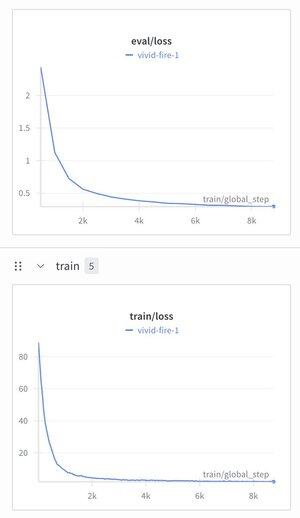

Postanowiłem wziąć model rozumowania hierarchicznego i nałożyć na niego tokenizer tekstu, żeby zobaczyć, co się stanie.

Wytrenowałem go na zbiorze danych do dostosowywania instrukcji (Alpaca) i byłem zdumiony, widząc, że strata spadła do ~1.9.

Obecnie produkuje dobrze uformowane śmieci, ale prawdopodobnie potrzebuje wstępnego treningu, ale to jest dość duże, jeśli to zadziała...

295

Najlepsze

Ranking

Ulubione