Tópicos em alta

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

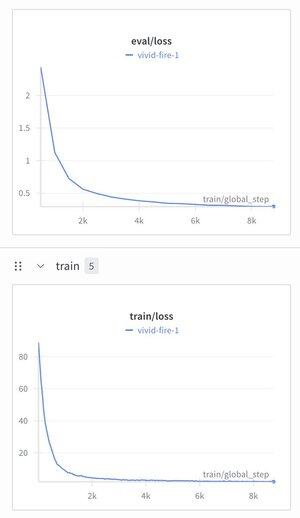

Decidi pegar o Modelo de Raciocínio Hierárquico e colocar um tokenizador de texto nele apenas para ver o que aconteceria.

Treinou-o em um conjunto de dados de ajuste de instrução (Alpaca), fiquei surpreso ao ver a perda cair para ~ 1,9.

Produz lixo bem padrão agora ainda, provavelmente precisa de pré-treinamento, mas isso é meio grande se funcionar ...

297

Melhores

Classificação

Favoritos