Актуальные темы

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

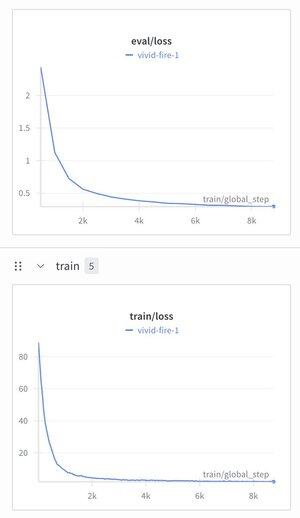

Я решил взять иерархическую модель рассуждений и наложить на нее текстовый токенизатор, просто чтобы посмотреть, что произойдет.

Обучил ее на наборе данных для настройки инструкций (Alpaca), был поражен, увидев, что потеря снизилась до ~1.9.

Сейчас она все еще производит хорошо структурированный мусор, вероятно, ей нужно предварительное обучение, но это довольно важно, если это сработает...

360

Топ

Рейтинг

Избранное