Rubriques tendance

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

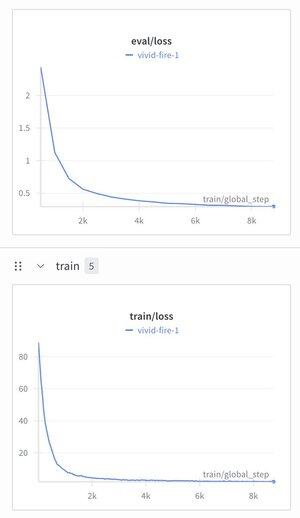

J'ai décidé de prendre le Modèle de Raisonnement Hiérarchique et d'y ajouter un tokenizer de texte juste pour voir ce qui se passerait.

Je l'ai entraîné sur un ensemble de données de réglage d'instructions (Alpaca), et j'ai été étonné de voir la perte descendre à ~1,9.

Il produit encore des déchets bien structurés pour l'instant, il a probablement besoin d'un pré-entraînement, mais c'est plutôt important si ça fonctionne...

290

Meilleurs

Classement

Favoris