Populaire onderwerpen

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

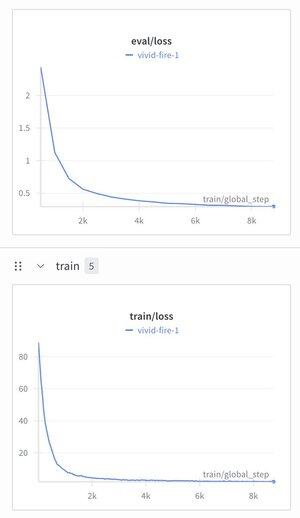

Ik besloot het Hiërarchisch Redeneringsmodel te nemen en er een teksttokenizer op te zetten om te zien wat er zou gebeuren.

Ik trainde het op een instructie-afstemmingsdataset (Alpaca) en was verbaasd te zien dat het verlies daalde tot ~1,9.

Het produceert momenteel nog steeds goed gepatterde rommel, het heeft waarschijnlijk pre-training nodig, maar dit is best groot als het werkt...

298

Boven

Positie

Favorieten