Tendencias del momento

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

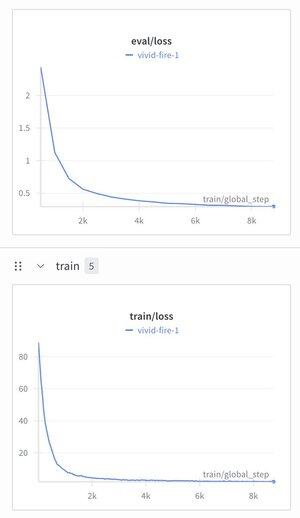

Decidí tomar el Modelo de Razonamiento Jerárquico y ponerle un tokenizador de texto solo para ver qué pasaba.

Lo entrené en un conjunto de datos de ajuste de instrucciones (Alpaca), y me sorprendió ver que la pérdida bajaba a ~1.9.

Ahora mismo produce basura bien estructurada, todavía necesita pre-entrenamiento probablemente, pero esto es bastante importante si funciona...

300

Parte superior

Clasificación

Favoritos