Populaire onderwerpen

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

Benieuwd hoe goed SFT werkt in vergelijking met in-context leren.

ICL voelt als zwarte magie - het model pikt echt een hoop impliciete informatie op met menselijke monster efficiëntie.

Als fine-tuning daar dichtbij kan komen, misschien kun je iets in elkaar knutselen dat aanvoelt als continue leren daarbovenop?

Hier is een naïef idee: Binnenste lus, doe SFT op sessiesamenvattingen. Buitenkant, lange horizon RL waar het gebruik moet maken van vaardigheden en kennis die tussen sessies moeten worden doorgegeven. De buitenste lus behandelt SFT in wezen als een tool-aanroep, waarbij het model wordt gestimuleerd om zoveel mogelijk belangrijke informatie door te geven.

Ik ben benieuwd of iets dat bestaande technieken zoals deze samenvoegt genoeg zal zijn voor continue leren, of dat we een geheel nieuw paradigma nodig hebben.

Heb een leuke Fermi-schatting gedaan met ChatGPT om wat intuïtie rond deze vraag te krijgen.

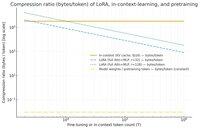

Een vraag die je zou kunnen stellen is, hoeveel comprimeert SFT (via LoRA) informatie in vergelijking met in-context leren? En vergelijk het voor de lol met pretraining.

Als er een enorme discrepantie is (oftewel er zijn veel meer bytes gebruikt voor de KV-caches in vergelijking met de gewichten van de LoRA), dan *kan* dat suggereren dat het heel moeilijk zou zijn voor LoRA om net zo rijk en monster efficiënt te zijn als ICL.

Nogmaals, dit is een super vage middag rabbit hole, geen serieuze onderzoek. Alleen omdat het veel minder geheugen gebruikt, betekent niet noodzakelijk dat het veel dommer is, enz.

Deze grafiek is voor Llama 3 70 b (dat is voorgetraind op 15 biljoen tokens).

Zodra we bij de enkelcijferige duizenden tokens komen, moet de LoRA (wiens grootte niet verandert met hoeveel tokens je fine-tuning doet) veel dichter comprimeren dan ICL.

Zodra je 100k tokens hebt, worden de tokens die door een rank-32 LoRA gaan 37x meer gecomprimeerd dan als ze in-context (via de KV-cache) zouden worden behandeld.

Tussenopmerking: de bytes per trainings-token voor pretraining zijn ongelooflijk laag! (0.009 in dit geval).

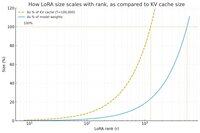

Heb nog een grafiek gemaakt, deze keer de token telling constant gehouden op 100k, en de rang van de LoRA gevarieerd.

Naïef lijkt het erop dat de rang klein genoeg moet zijn zodat het slechts een klein percentage van de totale modelgewichten is (anders, waarom zou je met een LoRA werken?), maar ook groot genoeg om een significante hoeveelheid van de informatie opgeslagen in KV-caches te bevatten. Dus je kunt zien waar dat zoete punt zou kunnen zijn.

Hoe dan ook, deze grafieken zijn niet concluderend voor iets. En excuses voor eventuele gênante fouten of misverstanden.

Ben benieuwd naar echte high-level meningen over hoe goed het samenvoegen van SFT en RL zal werken in termen van het maken van het continue leren dat we zien met in-context leren tussen sessies.

35,94K

Boven

Positie

Favorieten