Topik trending

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

Penasaran seberapa baik SFT bekerja relatif terhadap pembelajaran konteks.

ICL merasakan ilmu hitam - model ini benar-benar mengambil banyak informasi diam-diam pada efisiensi sampel manusia.

Jika penyetelan halus dapat mendekati itu, mungkin Anda dapat mengumpulkan sesuatu yang terasa seperti belajar terus menerus di atasnya?

Inilah ide yang naif: Loop dalam, lakukan SFT pada ringkasan sesi. Loop luar, RL cakrawala panjang di mana ia harus memanfaatkan keterampilan dan pengetahuan yang harus dilewati di antara sesi. Loop luar pada dasarnya memperlakukan SFT sebagai panggilan alat, memberi insentif kepada model untuk melewati sebanyak mungkin informasi penting.

Saya ingin tahu apakah sesuatu yang menyatukan teknik yang ada seperti ini akan cukup untuk pembelajaran berkelanjutan, atau apakah kita membutuhkan paradigma yang sama sekali baru.

Melakukan perkiraan Fermi yang menyenangkan dengan ChatGPT untuk mendapatkan intuisi seputar pertanyaan ini.

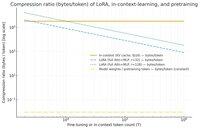

Pertanyaan yang dapat Anda tanyakan adalah, seberapa banyak SFT (melalui LoRA) mengompresi informasi relatif terhadap pembelajaran dalam konteks? Dan bandingkan dengan pra-pelatihan hanya untuk bersenang-senang.

Jika ada perbedaan besar (alias ada banyak byte yang digunakan untuk cache KV dibandingkan dengan bobot LoRA), maka itu *mungkin* menunjukkan bahwa akan sangat sulit bagi LoRA untuk menjadi kaya dan efisien sampel dan ICL.

Sekali lagi, ini adalah lubang kelinci sore yang sangat beralonda, bukan penyelidikan yang serius. Hanya karena menggunakan memori yang jauh lebih sedikit tidak berarti itu jauh lebih bodoh, dll.

Grafik ini untuk Llama 3 70 b (yang telah dilatih sebelumnya pada 15 triliun token).

Setelah kita mencapai ribuan token satu digit, LoRA (yang ukurannya tidak berubah dengan berapa banyak token yang Anda sesuaikan) mulai harus dikompresi jauh lebih padat daripada ICL.

Setelah Anda memiliki 100k token, token yang melalui LoRA peringkat-32 dikompresi 37x lebih banyak daripada jika diperhatikan dalam konteks (melalui cache KV).

Catatan samping: byte per token pelatihan untuk prapelatihan sangat rendah! (0,009 dalam hal ini).

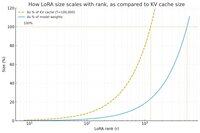

Lakukan grafik lain, kali ini menahan jumlah token konstan pada 100k, dan memvariasikan peringkat LoRA.

Secara naif, tampaknya peringkatnya harus cukup kecil sehingga hanya sebagian kecil dari total bobot model (jika tidak, mengapa repot-repot dengan LoRA?), tetapi juga cukup besar untuk berisi sejumlah besar informasi yang disimpan dalam cache KV. Jadi Anda dapat melihat di mana sweet spot itu.

Bagaimanapun, grafik ini tidak meyakinkan apa pun. Dan mohon maafkan kesalahan atau kesalahpahaman yang memalukan.

Ingin mendapatkan pandangan tingkat tinggi yang sebenarnya tentang seberapa baik menggabungkan SFT dan RL akan bekerja dalam hal membuat pembelajaran berkelanjutan yang kita lihat dengan pembelajaran dalam konteks bekerja di antara sesi.

40,88K

Teratas

Peringkat

Favorit