Populární témata

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

Zajímalo by mě, jak dobře SFT funguje ve srovnání s kontextovým učením.

ICL působí jako černá magie – model ve skutečnosti zachycuje spoustu nevyslovených informací s efektivitou lidského vzorku.

Pokud se tomu jemné ladění může přiblížit, možná byste mohli dát dohromady něco, co vám připadá jako neustálé učení se nahoře?

Zde je naivní nápad: Vnitřní smyčka, proveďte SFT na souhrnech sezení. Vnější smyčka, RL s dlouhým horizontem, kde je třeba využít dovednosti a znalosti, které musí projít mezi relacemi. Vnější smyčka v podstatě zachází se SFT jako s voláním nástroje, který motivuje model k tomu, aby prošel co nejvíce důležitými informacemi.

Jsem zvědavý, zda něco, co spojuje existující techniky, jako je tato, bude stačit pro neustálé učení, nebo zda potřebujeme úplně nové paradigma.

Udělal jsem zábavný Fermiho odhad pomocí ChatGPT, abych získal určitou intuici ohledně této otázky.

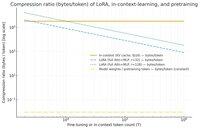

Otázka, kterou si můžete položit, je, jak moc SFT (prostřednictvím LoRA) komprimuje informace ve vztahu k kontextovému učení? A přirovnejte to k předtréninku jen tak pro zábavu.

Pokud existuje obrovský nepoměr (neboli existuje mnohonásobně tolik bajtů použitých pro KV cache ve srovnání s váhami LoRA), pak to *může* naznačovat, že by bylo velmi obtížné, aby LoRA byla tak bohatá a vzorkově efektivní a ICL.

Opět se jedná o super vlnící se odpolední králičí noru, nikoli o seriózní vyšetřování. To, že využívá mnohem méně paměti, nemusí nutně znamenat, že je mnohem hloupější atd.

Tento graf je pro lamu 3 70 b (která byla předtrénována na 15 bilionech tokenů).

Jakmile se dostaneme na jednociferné hodnoty tisíců tokenů, LoRA (jejíž velikost se nemění s tím, kolik tokenů dolaďujete) začne muset komprimovat mnohem hustěji než ICL.

Jakmile máte 100 tisíc tokenů, tokeny procházející LoRA hodnosti 32 jsou komprimovány 37x více, než kdyby byly obsluhovány v kontextu (prostřednictvím mezipaměti KV).

Poznámka na okraj: bajty na trénovací token pro předtrénování jsou neuvěřitelně nízké! (v tomto případě 0,009).

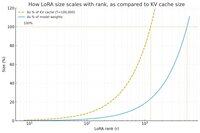

Udělal další graf, tentokrát ponechal počet tokenů konstantní na 100 tisících a změnil pořadí LoRA.

Naivně se zdá, že hodnost by měla být dostatečně malá, aby to byl jen malý zlomek celkových vah modelu (jinak proč se obtěžovat s LoRA?), ale také dostatečně velká, aby obsahovala značné množství informací uložených v KV cache. Takže můžete vidět, kde by mohlo být to sladké místo.

Každopádně tyto grafy nejsou k ničemu průkazné. A omluvte prosím případné trapné chyby nebo nedorozumění.

Chceme získat skutečné názory na vysoké úrovni na to, jak dobře bude fungovat spojení SFT a RL, pokud jde o to, aby kontinuální učení, které vidíme u kontextového učení mezi sezeními.

40,62K

Top

Hodnocení

Oblíbené