Rubriques tendance

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

Curieux de savoir à quel point SFT fonctionne par rapport à l'apprentissage en contexte.

L'ICL semble de la magie noire - le modèle capte vraiment un tas d'informations tacites avec une efficacité d'échantillonnage humaine.

Si le fine-tuning peut s'en rapprocher, peut-être pouvez-vous assembler quelque chose qui ressemble à un apprentissage continu par-dessus ?

Voici une idée naïve : boucle interne, faire SFT sur les résumés de session. Boucle externe, RL à long terme où il doit utiliser des compétences et des connaissances qui doivent passer entre les sessions. La boucle externe traite essentiellement SFT comme un appel d'outil, incitant le modèle à transmettre autant d'informations importantes que possible.

Je me demande si quelque chose qui assemble des techniques existantes comme celle-ci sera suffisant pour l'apprentissage continu, ou si nous avons besoin d'un tout nouveau paradigme.

J'ai fait une estimation amusante de Fermi avec ChatGPT pour obtenir une intuition autour de cette question.

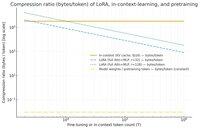

Une question que vous pourriez poser est : combien SFT (via LoRA) compresse-t-il l'information par rapport à l'apprentissage en contexte ? Et le comparer à la préformation juste pour le plaisir.

S'il y a un énorme écart (c'est-à-dire qu'il y a plusieurs fois plus d'octets utilisés pour les caches KV par rapport aux poids de LoRA), alors cela *pourrait* suggérer qu'il serait très difficile pour LoRA d'être aussi riche et efficace en échantillonnage que l'ICL.

Encore une fois, c'est un trou de lapin d'après-midi super vague, pas une enquête sérieuse. Juste parce que cela utilise beaucoup moins de mémoire ne signifie pas nécessairement que c'est beaucoup plus bête, etc.

Ce graphique est pour Llama 3 70 b (qui a été préentraîné sur 15 trillions de tokens).

Une fois que nous atteignons les milliers de tokens à un chiffre, le LoRA (dont la taille ne change pas avec le nombre de tokens sur lesquels vous faites du fine-tuning) commence à devoir compresser beaucoup plus densément que l'ICL.

Une fois que vous avez 100k tokens, les tokens passant par un LoRA de rang 32 sont compressés 37 fois plus que s'ils étaient traités en contexte (via le cache KV).

Remarque : les octets par token d'entraînement pour la préformation sont incroyablement bas ! (0,009 dans ce cas).

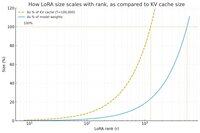

J'ai fait un autre graphique, cette fois en maintenant le nombre de tokens constant à 100k, et en variant le rang du LoRA.

Naïvement, il semble que le rang devrait être suffisamment petit pour qu'il ne soit qu'une petite fraction des poids totaux du modèle (sinon, pourquoi se donner la peine avec un LoRA ?), mais aussi assez grand pour contenir une quantité significative des informations stockées dans les caches KV. Donc, vous pouvez voir où pourrait se situer ce point idéal.

Quoi qu'il en soit, ces graphiques ne sont conclusifs sur rien. Et veuillez excuser toute erreur embarrassante ou malentendu.

Je suis impatient d'obtenir des avis de haut niveau sur la façon dont l'assemblage de SFT et RL fonctionnera en termes de rendre l'apprentissage continu que nous voyons avec l'apprentissage en contexte fonctionnel entre les sessions.

40,63K

Meilleurs

Classement

Favoris