Chủ đề thịnh hành

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

Tò mò không biết SFT hoạt động tốt như thế nào so với học trong ngữ cảnh.

ICL cảm thấy như ma thuật - mô hình thực sự đang tiếp thu một đống thông tin ngầm với hiệu suất mẫu của con người.

Nếu tinh chỉnh có thể gần đạt được điều đó, có lẽ bạn có thể kết hợp lại một cái gì đó mà cảm giác như học liên tục ở trên?

Đây là một ý tưởng ngây thơ: Vòng lặp bên trong, thực hiện SFT trên các tóm tắt phiên. Vòng lặp bên ngoài, RL dài hạn nơi nó phải sử dụng các kỹ năng và kiến thức phải được truyền giữa các phiên. Vòng lặp bên ngoài về cơ bản coi SFT như một cuộc gọi công cụ, khuyến khích mô hình truyền đạt càng nhiều thông tin quan trọng càng tốt.

Tôi tò mò không biết liệu một cái gì đó kết hợp các kỹ thuật hiện có như thế này có đủ cho việc học liên tục hay không, hoặc liệu chúng ta có cần một mô hình hoàn toàn mới.

Đã thực hiện một ước lượng Fermi thú vị với ChatGPT để có được một số trực giác xung quanh câu hỏi này.

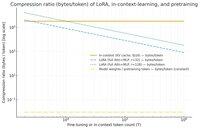

Một câu hỏi bạn có thể đặt ra là, SFT (thông qua LoRA) nén thông tin như thế nào so với học trong ngữ cảnh? Và so sánh nó với việc tiền huấn luyện chỉ để vui.

Nếu có sự chênh lệch lớn (tức là có nhiều byte hơn được sử dụng cho các bộ nhớ KV so với trọng số của LoRA), thì điều đó *có thể* gợi ý rằng sẽ rất khó để LoRA phong phú và hiệu quả mẫu như ICL.

Một lần nữa, đây là một cái hố thỏ buổi chiều siêu mơ hồ, không phải là một cuộc điều tra nghiêm túc. Chỉ vì nó sử dụng ít bộ nhớ hơn không nhất thiết có nghĩa là nó ngu ngốc hơn, v.v.

Biểu đồ này là cho Llama 3 70 b (đã được tiền huấn luyện trên 15 triệu token).

Khi chúng ta đạt đến hàng ngàn token đơn, LoRA (có kích thước không thay đổi với số lượng token bạn đang tinh chỉnh) bắt đầu phải nén nhiều hơn so với ICL.

Khi bạn có 100k token, các token đi qua một LoRA hạng 32 đang bị nén 37 lần nhiều hơn so với nếu chúng được chú ý trong ngữ cảnh (thông qua bộ nhớ KV).

Lưu ý: số byte cho mỗi token huấn luyện cho việc tiền huấn luyện là cực kỳ thấp! (0.009 trong trường hợp này).

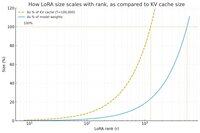

Đã thực hiện một biểu đồ khác, lần này giữ số lượng token cố định ở 100k, và thay đổi hạng của LoRA.

Ngây thơ mà nói, có vẻ như hạng nên đủ nhỏ để chỉ là một phần nhỏ của tổng trọng số mô hình (nếu không, tại sao lại bận tâm với một LoRA?), nhưng cũng đủ lớn để chứa một lượng thông tin đáng kể được lưu trữ trong bộ nhớ KV. Vì vậy, bạn có thể thấy vị trí ngọt ngào đó có thể ở đâu.

Dù sao đi nữa, những biểu đồ này không kết luận điều gì. Và xin hãy tha thứ cho bất kỳ sai sót hay hiểu lầm nào đáng xấu hổ.

40,63K

Hàng đầu

Thứ hạng

Yêu thích