Trendande ämnen

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

Nyfiken på hur bra SFT fungerar i förhållande till i kontextlärande.

ICL känner svart magi - modellen plockar verkligen upp en massa underförstådd information om mänsklig proveffektivitet.

Om finjusteringen kan komma i närheten av det, kanske du kan skrapa ihop något som känns som ett ständigt lärande på toppen?

Här är en naiv idé: Inre loop, gör SFT på sessionssammanfattningar. Yttre loop, lång horisont RL där den måste använda sig av färdigheter och kunskaper som måste passera mellan sessionerna. Outer loop behandlar i princip SFT som ett verktygsanrop, vilket uppmuntrar modellen att passera så mycket viktig information som möjligt.

Jag är nyfiken på om något som klumpar ihop befintliga tekniker på det här sättet kommer att räcka för kontinuerligt lärande, eller om vi behöver ett helt nytt paradigm.

Gjorde en rolig Fermi-uppskattning med ChatGPT för att få lite intuition kring denna fråga.

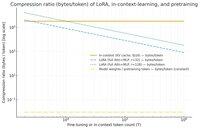

En fråga du kan ställa dig är, hur mycket komprimerar SFT (via LoRA) information i förhållande till i kontextinlärning? Och jämför det med förträning bara för skojs skull.

Om det finns en enorm skillnad (aka det finns många gånger så många byte som används för KV-cacher jämfört med vikterna för LoRA), så kan det * tyda på att det skulle vara mycket svårt för LoRA att vara lika rik och proveffektiv och ICL.

Återigen, detta är ett superhandvågigt eftermiddagskaninhål, inte en seriös undersökning. Bara för att det använder mycket mindre minne betyder det inte nödvändigtvis att det är mycket dummare, etc.

Den här grafen är för Llama 3 70 b (som förtränades på 15 biljoner tokens).

När vi kommer upp till ensiffriga tusentals tokens börjar LoRA (vars storlek inte ändras med hur många tokens du finjusterar) att behöva komprimera mycket tätare än ICL.

När du har 100k tokens komprimeras de tokens som går igenom en rank-32 LoRA 37 gånger mer än om de uppmärksammades i sammanhanget (via KV-cachen).

Sidenote: byte per träningstoken för förträning är otroligt låga! (0,009 i det här fallet).

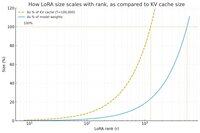

Gjorde en annan graf, den här gången höll tokenräkningen konstant på 100k och varierade rankningen av LoRA.

Naivt nog verkar det som att rangen borde vara tillräckligt liten så att den bara är en liten bråkdel av de totala modellvikterna (annars, varför bry sig om en LoRA?), men också tillräckligt stor för att innehålla en betydande mängd av den information som lagras i KV-cacher. Så du kan se var den söta platsen kan vara.

Hur som helst, dessa grafer är inte avgörande för någonting. Och vi ber om ursäkt för eventuella pinsamma misstag eller missförstånd.

Ivrig att få faktiska högnivåuppfattningar om hur väl sammanfogning av SFT och RL kommer att fungera när det gäller att få det kontinuerliga lärandet vi ser med in-context-lärande att fungera mellan sessionerna.

40,59K

Topp

Rankning

Favoriter