Populære emner

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

Nysgjerrig på hvor godt SFT fungerer i forhold til i kontekstlæring.

ICL føler svart magi - modellen plukker virkelig opp en haug med stilltiende informasjon på menneskelig prøveeffektivitet.

Hvis finjustering kan komme i nærheten av det, kan du kanskje klaske sammen noe som føles som kontinuerlig læring på toppen?

Her er en naiv idé: Inner loop, gjør SFT på øktsammendrag. Ytre sløyfe, langhorisont RL hvor den må benytte seg av ferdigheter og kunnskaper som må passere mellom øktene. Outer loop behandler i utgangspunktet SFT som et verktøykall, og oppmuntrer modellen til å sende gjennom så mye viktig informasjon som mulig.

Jeg er nysgjerrig på om noe som slår sammen eksisterende teknikker som dette vil være nok for kontinuerlig læring, eller om vi trenger et helt nytt paradigme.

Gjorde et morsomt Fermi-estimat med ChatGPT for å få litt intuisjon rundt dette spørsmålet.

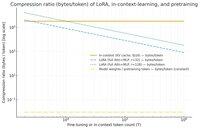

Et spørsmål du kan stille er, hvor mye komprimerer SFT (via LoRA) informasjon i forhold til kontekstlæring? Og sammenlign det med førtrening bare for moro skyld.

Hvis det er en stor forskjell (aka det er mange ganger så mange byte som brukes for KV-cachene sammenlignet med vektene til LoRA), så *kan* det antyde at det ville være veldig vanskelig for LoRA å være så rik og sample effektiv og ICL.

Igjen, dette er et superhåndbølget ettermiddagskaninhull, ikke en seriøs etterforskning. Bare fordi den bruker mye mindre minne betyr det ikke nødvendigvis at den er mye dummere osv.

Denne grafen er for Llama 3 70 b (som ble forhåndstrent på 15 billioner tokens).

Når vi kommer opp til ensifrede tusenvis av tokens, begynner LoRA (hvis størrelse ikke endres med hvor mange tokens du finjusterer på) å måtte komprimere mye tettere enn ICL.

Når du har 100k tokens, blir tokenene som går gjennom en rang-32 LoRA komprimert 37 ganger mer enn om de ble ivaretatt i kontekst (via KV-cachen).

Sidenote: byte per treningstoken for pretraining er utrolig lave! (0,009 i dette tilfellet).

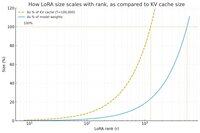

Gjorde en ny graf, denne gangen holdt token-antallet konstant på 100k, og varierte rangeringen til LoRA.

Naivt ser det ut til at rangeringen bør være liten nok til at den bare er en liten brøkdel av de totale modellvektene (ellers, hvorfor bry seg med en LoRA?), men også stor nok til å inneholde en betydelig mengde av informasjonen som er lagret i KV-cacher. Så du kan se hvor det søte stedet kan være.

Uansett, disse grafene er ikke avgjørende for noe. Og vær så snill å unnskylde eventuelle pinlige feil eller misforståelser.

Ivrig etter å få faktiske høye nivåer på hvor godt det å slå sammen SFT og RL vil fungere når det gjelder å få den kontinuerlige læringen vi ser med kontekstlæring til å fungere mellom øktene.

40,62K

Topp

Rangering

Favoritter