Subiecte populare

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

Curios cât de bine funcționează SFT în raport cu învățarea în context.

ICL simte magia neagră - modelul într-adevăr colectează o grămadă de informații tacite la eficiența eșantionului uman.

Dacă reglarea fină se poate apropia de asta, poate puteți pune cap la cap ceva care se simte ca o învățare continuă deasupra?

Iată o idee naivă: buclă interioară, faceți SFT pe rezumatele sesiunilor. Buclă exterioară, RL cu orizont lung unde trebuie să folosească abilitățile și cunoștințele care trebuie să treacă între sesiuni. Bucla exterioară tratează practic SFT ca pe un apel de instrument, stimulând modelul să treacă prin cât mai multe informații importante.

Sunt curios dacă ceva care îmbină tehnicile existente ca aceasta va fi suficient pentru învățarea continuă sau dacă avem nevoie de o paradigmă cu totul nouă.

Am făcut o estimare amuzantă a lui Fermi cu ChatGPT pentru a obține o intuiție în jurul acestei întrebări.

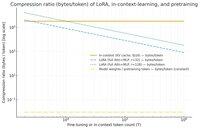

O întrebare pe care ați putea-o pune este, cât de mult comprimă SFT (prin LoRA) informațiile în raport cu învățarea în context? Și comparați-l cu preantrenamentul doar pentru distracție.

Dacă există o diferență uriașă (adică există de mulți octeți folosiți pentru cache-urile KV în comparație cu greutățile LoRA), atunci ar putea sugera că ar fi foarte greu pentru LoRA să fie la fel de bogat și eficient în eșantionare și ICL.

Din nou, aceasta este o gaură de iepure de după-amiază, nu o investigație serioasă. Doar pentru că folosește mult mai puțină memorie nu înseamnă neapărat că este mult mai prost etc.

Acest grafic este pentru Llama 3 70 b (care a fost antrenat în prealabil pe 15 trilioane de jetoane).

Odată ce ajungem la mii de jetoane cu o singură cifră, LoRA (a cărui dimensiune nu se schimbă în funcție de numărul de jetoane pe care le reglați) începe să se comprime mult mai dens decât ICL.

Odată ce aveți 100k jetoane, jetoanele care trec printr-un LoRA de rang 32 sunt comprimate de 37 de ori mai mult decât dacă ar fi luate în considerare în context (prin cache-ul KV).

Notă: octeții per token de antrenament pentru preantrenament sunt incredibil de mici! (0,009 în acest caz).

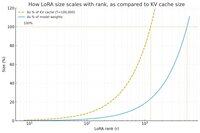

Am făcut un alt grafic, de data aceasta menținând constant numărul de jetoane la 100k și variind rangul LoRA.

Naiv, se pare că rangul ar trebui să fie suficient de mic, astfel încât să fie doar o mică fracțiune din greutatea totală a modelului (altfel, de ce să ne deranjăm cu un LoRA?), dar și suficient de mare pentru a conține o cantitate semnificativă de informații stocate în cache-urile KV. Deci puteți vedea unde ar putea fi acel punct dulce.

Oricum, aceste grafice nu sunt concludente pentru nimic. Și vă rugăm să scuzați orice greșeli sau neînțelegeri jenante.

Dornic să obțină opinii reale de nivel înalt despre cât de bine vor funcționa SFT și RL în ceea ce privește învățarea continuă pe care o vedem cu învățarea în context funcționează între sesiuni.

40,59K

Limită superioară

Clasament

Favorite