Актуальні теми

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

Цікаво, наскільки добре працює SFT щодо навчання в контексті.

ICL відчуває чорну магію - модель дійсно збирає купу негласної інформації при ефективності людських зразків.

Якщо тонке налаштування може наблизитися до цього, можливо, ви зможете зібрати воєдино щось, що здається постійним навчанням на вершині?

Ось наївна ідея: Внутрішня петля, робіть SFT на підсумках сесій. Зовнішня петля, довгий горизонт RL, де він повинен використовувати навички та знання, які повинні пройти між сесіями. Зовнішній контур в основному розглядає SFT як виклик інструменту, стимулюючи модель передавати якомога більше важливої інформації.

Мені цікаво, чи вистачить чогось, що об'єднує існуючі методи, як ця, для постійного навчання, чи нам потрібна абсолютно нова парадигма.

Зробив кумедну оцінку Фермі з ChatGPT, щоб отримати трохи інтуїції в цьому питанні.

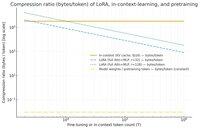

Питання, яке ви можете задати: наскільки SFT (через LoRA) стискає інформацію відносно контекстного навчання? І порівняйте це з попередніми тренуваннями просто для задоволення.

Якщо існує величезна невідповідність (тобто в набагато більше байтів, використаних для кеш-пам'яті KV, порівняно з вагою LoRA), то це може свідчити про те, що для LoRA було б дуже важко бути настільки багатим, ефективним за вибіркою та ICL.

Знову ж таки, це супер хвиляста післяобідня кроляча нора, а не серйозне розслідування. Те, що він використовує набагато менше пам'яті, не обов'язково означає, що він набагато дурніший тощо.

Цей графік призначений для Llama 3 70 b (яка була попередньо навчена на 15 трильйонів токенів).

Як тільки ми досягаємо однозначних тисяч токенів, LoRA (розмір якого не змінюється в залежності від того, скільки токенів ви налаштовуєте) починає стискатися набагато щільніше, ніж ICL.

Як тільки у вас є 100 тисяч токенів, токени, що проходять через LoRA 32 рангу, стискаються в 37 разів більше, ніж якби вони розглядалися в контексті (через кеш KV).

Примітка: байти на тренувальний токен для попереднього тренування неймовірно низькі! (0,009 в даному випадку).

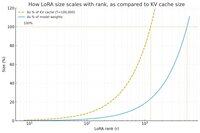

Зробив ще один графік, цього разу встановивши постійну кількість токенів на рівні 100 тисяч і змінивши ранг LoRA.

Наївно, здається, що ранг має бути достатньо маленьким, щоб становити лише невелику частку від загальної ваги моделі (інакше, навіщо морочитися з LoRA?), але й достатньо великим, щоб містити значний обсяг інформації, що зберігається в кешах KV. Тож ви можете побачити, де може бути ця золота середина.

У всякому разі, ці графіки ні про що не переконують. І, будь ласка, вибачте за прикрі помилки або непорозуміння.

Прагнучи отримати реальний високий рівень, ми розуміємо, наскільки добре поєднання SFT і RL працюватиме з точки зору забезпечення безперервного навчання, яке ми бачимо з контекстним навчанням, працюючи між сесіями.

40,58K

Найкращі

Рейтинг

Вибране