Trendaavat aiheet

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

Utelias, kuinka hyvin SFT toimii suhteessa kontekstioppimiseen.

ICL tuntuu mustalta magialta - malli todella poimii joukon hiljaista tietoa ihmisnäytteiden tehokkuudesta.

Jos hienosäätö pääsee lähellekään sitä, ehkä voit koota jotain, joka tuntuu jatkuvalta oppimiselta?

Tässä on naiivi idea: Sisempi silmukka, tee SFT istuntojen yhteenvedoista. Ulompi silmukka, pitkän horisontin RL, jossa sen on hyödynnettävä taitoja ja tietoja, jotka on siirrettävä istuntojen välillä. Outer loop käsittelee SFT:tä periaatteessa työkalukutsuna, joka kannustaa mallia välittämään mahdollisimman paljon tärkeää tietoa.

Olen utelias, riittääkö jokin, joka sekoittaa olemassa olevat tekniikat, jatkuvaan oppimiseen, vai tarvitsemmeko kokonaan uuden paradigman.

Tein hauskan Fermi-arvion ChatGPT:n kanssa saadakseni intuitiota tämän kysymyksen ympärille.

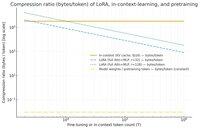

Voisit kysyä, kuinka paljon SFT (LoRA:n kautta) tiivistää tietoa suhteessa kontekstioppimiseen? Ja vertaa sitä esiharjoitteluun vain huvin vuoksi.

Jos on valtava ero (eli KV-välimuistissa käytetään monta kertaa enemmän tavuja kuin LoRA:n painot), se *saattaa* viitata siihen, että LoRA:n olisi erittäin vaikeaa olla yhtä rikas ja näytteiden tehokas ja ICL.

Jälleen kerran, tämä on erittäin käsinaaltoileva iltapäivän kaninkolo, ei vakava tutkimus. Se, että se käyttää paljon vähemmän muistia, ei välttämättä tarkoita, että se olisi paljon tyhmempi jne.

Tämä kaavio on Llama 3 70 b:lle (joka oli esikoulutettu 15 biljoonalla tokenilla).

Kun pääsemme yksinumeroisiin tuhansiin tokeneihin, LoRA (jonka koko ei muutu sen mukaan, kuinka monta tokenia hienosäädät) alkaa pakata paljon tiheämmin kuin ICL.

Kun sinulla on 100k tokenia, tason 32 LoRA:n läpi kulkevat tokenit pakataan 37 kertaa enemmän kuin jos niitä hoidettaisiin kontekstissa (KV-välimuistin kautta).

Sivuhuomautus: tavujen määrä harjoitusmerkkiä kohden on uskomattoman alhainen! (tässä tapauksessa 0,009).

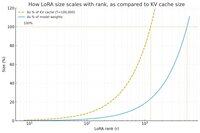

Tein toisen kaavion, tällä kertaa pidin tokenien määrän vakiona 100k:ssa, ja vaihteli LoRA:n sijoitusta.

Naiivisti näyttää siltä, että sijoituksen pitäisi olla tarpeeksi pieni niin, että se on vain pieni murto-osa mallin kokonaispainoista (muuten, miksi vaivautua LoRA:n kanssa?), mutta myös riittävän suuri sisältämään merkittävän määrän KV-välimuistiin tallennettua tietoa. Joten voit nähdä, missä se sauva paikka voisi olla.

Joka tapauksessa nämä kaaviot eivät ole ratkaisevia mistään. Ja pyydän anteeksi kaikki kiusalliset virheet tai väärinkäsitykset.

Halutessani saada todellista korkeatasoista näkemystä siitä, kuinka hyvin SFT:n ja RL:n yhdistäminen toimii, jotta jatkuva oppiminen, jonka näemme kontekstin sisäisessä oppimisessa, toimisi istuntojen välillä.

40,62K

Johtavat

Rankkaus

Suosikit