Populární témata

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

4 fáze školení LLM od nuly, jasně vysvětlené (s vizuálními prvky):

Dnes se zabýváme 4 fázemi vytváření LLM od nuly, aby byly použitelné pro případy použití v reálném světě.

Budeme se zabývat těmito tématy:

- Předtrénink

- Doladění instrukcí

- Doladění preferencí

- Doladění uvažování

Vizuál shrnuje tyto techniky.

Pojďme se ponořit!

0️⃣ Náhodně inicializované LLM

V tomto okamžiku model neví nic.

Zeptáte se "Co je to LLM?" a dostanete bláboly jako "zkuste petr ruku a ahoj 448Sn".

Zatím neviděl žádná data a má jen náhodné váhy.

Zkontrolujte toto 👇

1️⃣ Předtrénink

Tato fáze učí LLM základy jazyka tím, že jej trénuje na masivních korpusech, aby předpověděl další token. Tímto způsobem absorbuje gramatiku, světová fakta atd.

Ale není dobrý v konverzaci, protože když je vyzván, jen pokračuje v textu.

Zkontrolujte toto 👇

2️⃣ Jemné doladění pokynů

Aby to bylo konverzační, provádíme Instruction Fine-tuning tréninkem na párech instrukce-odpověď. To mu pomůže naučit se postupovat podle výzev a formátovat odpovědi.

Nyní může:

- Odpovídat na otázky

- Shrnutí obsahu

- Psát kód atd.

Zkontrolujte toto 👇

V tuto chvíli máme pravděpodobně:

- Využil jsem celý surový internetový archiv a znalosti.

- Rozpočet na data odpovědí na pokyny označená člověkem.

Co tedy můžeme udělat pro další vylepšení modelu?

Vstupujeme na území zpětnovazebního učení (RL).

Pojďme se naučit dále 👇

3️⃣ Jemné doladění preferencí (PFT)

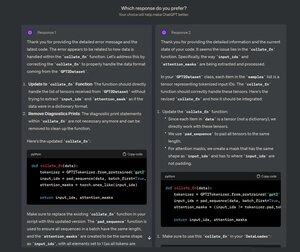

Určitě jste viděli tuto obrazovku na ChatGPT, kde se ptá: Kterou odpověď preferujete?

To není jen pro zpětnou vazbu, ale jsou to cenná data o lidských preferencích.

OpenAI to používá k doladění svých modelů pomocí jemného doladění preferencí.

Zkontrolujte toto 👇

V PFT:

Uživatel si vybírá mezi 2 odpověďmi, aby vytvořil údaje o lidských preferencích.

Model odměňování je poté trénován tak, aby předpovídal lidské preference a LLM je aktualizován pomocí RL.

Zkontrolujte toto 👇

Výše uvedený proces se nazývá RLHF (Reinforcement Learning with Human Feedback) a algoritmus používaný k aktualizaci vah modelu se nazývá PPO.

Učí LLM sladit se s lidmi, i když neexistuje žádná "správná" odpověď.

Ale můžeme LLM ještě vylepšit.

Pojďme se naučit dále👇

4️⃣ Jemné doladění uvažování

V úlohách uvažování (matematika, logika atd.) je obvykle pouze jedna správná odpověď a definovaná řada kroků k získání odpovědi.

Nepotřebujeme tedy lidské preference a můžeme použít korektnost jako signál.

Tomu se říká jemné doladění👇 uvažování

Schody:

- Model vygeneruje odpověď na výzvu.

- Odpověď je porovnána se známou správnou odpovědí.

- Na základě správnosti přiřadíme odměnu.

Tomu se říká zpětnovazební učení s ověřitelnými odměnami.

GRPO od DeepSeek je oblíbená technika.

Zkontrolujte toto👇

To byly 4 fáze školení LLM od nuly.

- Začněte s náhodně inicializovaným modelem.

- Předtrénujte jej na rozsáhlých korpusech.

- Použijte jemné doladění instrukcí, aby se řídil příkazy.

- Použijte jemné ladění preferencí a uvažování k zostření odpovědí.

Zkontrolujte toto 👇

Pokud vám to připadalo užitečné, sdílejte to znovu se svou sítí.

Najdi mě → @_avichawla

Každý den sdílím návody a postřehy o DS, ML, LLM a RAG.

21. 7. 2025

4 fáze školení LLM od nuly, jasně vysvětlené (s vizuálními prvky):

@tasiorek27 Jemné doladění výztuže:

Doladění instrukcí: (Nejedná se o trénování jako takové, ale spíše o generování datasetu pro jemné doladění instrukcí)

6. 5. 2025

Let's generate our own LLM fine-tuning dataset (100% local):

714,03K

Top

Hodnocení

Oblíbené