熱門話題

#

Bonk 生態迷因幣展現強韌勢頭

#

有消息稱 Pump.fun 計劃 40 億估值發幣,引發市場猜測

#

Solana 新代幣發射平臺 Boop.Fun 風頭正勁

從零開始訓練 LLM 的四個階段,清晰解釋(附視覺圖):

今天,我們將介紹從零開始構建 LLM 的四個階段,使其適用於現實世界的用例。

我們將涵蓋:

- 預訓練

- 指令微調

- 偏好微調

- 推理微調

這個視覺圖總結了這些技術。

讓我們深入了解!

0️⃣ 隨機初始化的 LLM

此時,模型什麼都不知道。

你問它「什麼是 LLM?」它會給出像「試試彼得手和你好 448Sn」這樣的胡言亂語。

它還沒有看到任何數據,僅僅擁有隨機的權重。

查看這個 👇

1️⃣ 預訓練

這個階段通過在大量語料庫上訓練 LLM 來教它語言的基本知識,以預測下一個標記。這樣,它吸收了語法、世界事實等。

但它不擅長對話,因為當被提示時,它只是繼續文本。

查看這個 👇

2️⃣ 指令微調

為了使其具備對話能力,我們通過訓練指令-回應對來進行指令微調。這有助於它學會如何遵循提示並格式化回覆。

現在它可以:

- 回答問題

- 總結內容

- 編寫代碼等等。

查看這個 👇

在這個階段,我們可能已經:

- 利用整個原始互聯網檔案和知識。

- 用於人類標記的指令回應數據的預算。

那麼我們可以做什麼來進一步改善模型呢?

我們進入強化學習(RL)的領域。

讓我們接下來學習 👇

3️⃣ 偏好微調 (PFT)

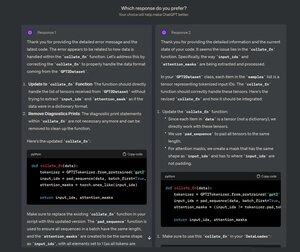

你一定見過 ChatGPT 上這個畫面,它會問:你更喜歡哪個回應?

這不僅僅是為了反饋,而是有價值的人類偏好數據。

OpenAI 利用這些數據來微調他們的模型,使用偏好微調。

查看這個 👇

在 PFT:

用戶在兩個回應之間選擇,以產生人類偏好數據。

然後訓練一個獎勵模型來預測人類偏好,並使用強化學習更新 LLM。

查看這個 👇

上述過程稱為 RLHF(人類反饋的強化學習),用於更新模型權重的算法稱為 PPO。

它教導 LLM 與人類對齊,即使在沒有 "正確" 答案的情況下。

但我們可以進一步改善 LLM。

讓我們接下來學習👇

4️⃣ 推理微調

在推理任務(數學、邏輯等)中,通常只有一個正確的回答和一系列明確的步驟來獲得答案。

因此,我們不需要人類的偏好,可以使用正確性作為信號。

這被稱為推理微調👇

步驟:

- 模型生成對提示的回答。

- 將回答與已知的正確答案進行比較。

- 根據正確性,我們分配獎勵。

這被稱為可驗證獎勵的強化學習。

DeepSeek 的 GRPO 是一種流行的技術。

查看這個👇

這些是從頭開始訓練法學碩士的 4 個階段。

- 從隨機初始化的模型開始。

- 在大規模語料庫上對其進行預訓練。

- 使用指令微調使其遵循命令。

- 使用偏好和推理微調來提高回應能力。

檢查這個 👇

如果您覺得它很有見地,請與您的網路重新分享。

找到我 → @_avichawla

每天,我都會分享有關 DS、ML、LLM 和 RAG 的教程和見解。

2025年7月21日

從零開始訓練 LLM 的四個階段,清晰解釋(附視覺圖):

@tasiorek27 強化微調:

指令微調:(這不是關於訓練本身,而是關於生成指令微調數據集)

2025年5月6日

Let's generate our own LLM fine-tuning dataset (100% local):

714.03K

熱門

排行

收藏